分布式锁

分布式锁是相对于JVM本地锁来说的,分布式锁能跨进程、跨服务、跨服务器来解决并发线程安全问题,使用分布式锁最多的两个场景是超卖现象和缓存击穿

对于超卖现象库存数据处于NoSQL数据库的时候分布式锁一定是最佳解决方案

类似于Mysql这种数据库数据以文件的形式存放在硬盘上,可以支持很高的数据量,但是性能很低,会导致系统吞吐量下降,系统可能被高并发请求冲垮;可以通过在mysql的上一层使用NoSql数据库如Redis加一层缓存,像Redis这种内存型数据库,性能高,但是支撑的数据量会比较小,随便一个Redis单节点都能支撑10w级别的并发量,Redis能对系统起到很好的保护作用并提升系统的性能

缓存击穿现象的原因是热点key过期,因为内存型数据库的内存是有限的,如果不给数据设置过期时间,内存最终就会被耗尽,因为缓存被设置了过期时间,缓存中数据一旦过期就会导致大量瞬时并发请求访问mysql获取热点数据,在并发量太大的情况下就会冲垮mysql数据库,此时可以在mysql前加一层锁来限制只让一个请求访问mysql数据库重建缓存

像缓存击穿这种场景使用JVM本地锁很多时候是无法满足实际业务需求的,因为一方面热点数据可能有很多,还是会发生短时大量请求访问数据库重建缓存,另一方面服务很少是确定永远就是单体部署,一旦有服务集群JVM本地锁就可能失效,老师说的上百个服务器太夸张了,其实使用JVM本地锁最多也就放几个十几个请求过去痛击数据库,当然热点数据一多并发量也会成倍数十倍的增长,即使用本地锁对系统还是有不可控的风险

分布式锁的实现方式主要有三种,分别是基于redis实现、基于Zookeeper/etcd实现、基于mysql实现,特征都是基于框架的性质来实现独占排他使用

概述

超卖现象

概念:

因为多个用户即多个线程并发访问共享库存数据,在不采取上锁等措施情况下因为多个线程的临界区代码执行次序错乱导致丢失部分数据更新操作,最终导致库存扣减小于实际的卖出数量,当库存耗尽前已经售出超过库存数量的商品导致无货可发,这就是超卖现象

缓存穿透

概念:查询一个一定不存在的数据,默认情况下没有该数据的缓存,由于缓存不命中,请求将会去查询数据库,但是数据库也没有该记录,如果不将此次查询的结果null写入缓存,那么相同的请求每次都会去请求数据库,如果有恶意请求针对不存在商品进行高频攻击,会给数据库造成瞬时高压,可能直接把数据库压垮

解决办法:

查询查不到结果,就将空结果也进行缓存,并设置一个短暂的过期时间,这样一方面是避免缓存过大,另一个方面是避免空值数据万一有了数据无法及时更新

也可以使用布隆过滤器对高频ip进行封禁

缓存雪崩

概念:设置缓存时key使用了相同的过期时间,导致缓存再某一时刻同时失效,然而此时的并发请求非常高,瞬间请求压力全部给到数据库,数据库瞬间压力过重雪崩

解决办法:在原有失效时间上添加一个短时间内的随机值【如1-5min随机】,这样每个缓存的过期时间重复率降低,从而很难发生极短时间内缓存集体失效的情况

缓存击穿

某些热点数据可能在瞬间突然被超高并发地访问,比如秒杀,但是对应的key正好在大量请求瞬间到来前已经失效,且在超高并发请求到来前没有请求再次形成缓存,那么瞬间的超高并发对同一个key对应的数据查询压力全部落在数据库上,称为缓存击穿,又比如一个接口只缓存一个数据结果,但是这个结果总会失效,失效的瞬间加入还是高并发请求【如首页商品分类数据】,此时所有并发查询压力就会直接加到数据库上

解决办法:

对重建缓存的过程加双重检查锁,对超高的瞬时并发,只让一个请求通过去重建缓存,剩下的请求都等待缓存

数据场景

共享数据的存储媒介,针对不同的存储场景列举和分析解决并发操作共享数据线程安全问题的手段

Mysql

共享资源如果放在mysql关系型数据库的情况下,要避免使用JVM本地锁,除非能避免锁和以下三种情况包括所在类使用多例模式、事务、服务集群部署任意一种共存,但是除了多例模式,事务和集群部署是很难避免的

我们还可以通过Mysql本身提供的锁机制来解决JVM本地锁失效的问题

数据场景

共享数据存在于Mysql数据库中,适用于系统并发量小的业务场景,多个线程在一个方法中并发对mysql中的共享数据进行先查后改操作,修改操作为对当前数据减1

测试

测试环境:100个用户线程,1s内每个用户线程发起50次扣减库存请求,总共发起5000次,场景为请求直连单个服务,服务操作虚拟机上的数据库

测试结果:仅操作服务本地缓存数据,没有涉及数据库时吞吐量为5000次/s;添加数据库,单个线程在一个方法内获取一次库存数据,更新一次库存数据,吞吐量减小为2000,数据库库存数据从5000变成4789,5000次扣减库存请求全部成功,理论上数据库库存应减为0,发生超卖现象,出现线程安全问题

解决方法

从性能上来说,一句SQL>>Mysql悲观锁>JVM本地锁>乐观锁

追求极致性能,业务场景简单且不需要记录数据前后变化的情况下优先选择一句sql

如果写并发量较低(多读少写),争抢不是很激烈的情况下优先选择乐观锁

❓:这有问题吧,乐观锁循环连接数据库,比JVM本地锁性能还差,慎重考虑

就mysql这个业务场景来说,如果写并发量较高竞争激烈,选择乐观锁会导致业务代码不间断的重试,优先选择mysql悲观锁

不推荐使用jvm本地锁

ReentrantLock

业务逻辑:对查数据库数据和更改数据库数据在服务器层面整体加可重入锁,用无锁并发的方式保证临界区代码原子性,实现对数据库数据的串行更新

测试

测试环境:100个用户线程,1s内每个用户线程发起50次扣减库存请求,总共发起5000次,场景为请求直连单个服务,服务操作虚拟机上的数据库

测试结果:吞吐量为544,所有库存扣减请求全部成功,数据库库存被正确减为0

结果分析:吞吐量减少相较于修改本地服务内存缓存降低了90%,对数据库访问和加可重入锁对系统并发性能削减很可观,访问数据库导致吞吐量减半,然后加可重入锁导致性能继续降低至访问数据库条件下吞吐量的25%【注意5000的吞吐量是在控制台进行了5000次打印操作,如果没有打印操作将会更高】

解决方法优缺点

ReentrantLock和Synchronized都属于JVM本地锁,拥有相同的优缺点,ReentrantLock解决线程安全问题方法的分析见Synchronized解决方法优缺点

Sychronized

业务逻辑:对查数据库数据和更改数据库数据在服务器层面整体加Synchronized,用锁独占阻塞的方式来保证临界区代码原子性

测试

测试环境:100个用户线程,1s内每个用户线程发起50次扣减库存请求,总共发起5000次,场景为请求直连单个服务,服务操作虚拟机上的数据库

测试结果:吞吐量为554,所有库存扣减请求全部成功,数据库库存被正确减为0

结果分析:synchronized和ReentrantLock在这种场景下性能差不多,ReentrantLock只是减少了上下文切换的性能开销

解决方案优缺点

三种情况可能导致JVM本地锁失效

多例模式可能导致JVM本地锁失效:ReentrantLock和Synchronized一般只能应用在单例对象的方法中来保护对共享成员变量的访问【比如在SpringBoot中的Service通过注入stockMapper来使用同一个单例Mapper操作数据库中的一个共享库存数据】,SpringBoot中默认service就是单例的,因此使用JVM本地锁使用能保证线程安全问题,但是一旦在service类名上通过配置

@Scope(value="prototype",proxyMode=ScopedProxyMode.TARGET_CLASS)将service改成多例的,ReentrantLock就可能变成多把锁,Synchronized如果是原本锁当前类对象,导致仍然会有多个线程同时操作共享数据出现线程安全问题,经过测试虽然吞吐量上来了变成了1811【几乎接近没上锁访问数据库】,但是发生了超卖现象,库存数量理论上为0实际上为4850,出现了线程安全问题使用单体事务注解

@Transactional可能导致JVM本地锁失效:在添加JVM本地锁的方法上添加事务注解@Transactional可能导致锁失效,锁失效是有概率的,不一定会失效,但是多线程并发的情况下概率也很高,锁失效的原理是事务注解@Transactional是通过AOP的方式来在方法执行前开启事务,在方法执行结束后提交事务,加上JVM锁以后单个线程的执行逻辑是开启事务--获取锁--操作数据库--释放锁--提交/回滚;如果是多个线程并发就可能在执行流程期间出现线程安全问题,原因是Mysql的默认隔离级别是可重复读,即已经完成的数据库操作还没有提交,查询操作就返回提交前的数据库数据。如果两个线程同时执行同一个上了JVM锁的方法,两个线程都开始事务然后去竞争锁,线程1抢到锁,线程2进入阻塞;线程1执行完数据库操作还没有提交就把锁释放了,因为Mysql的默认事务隔离级别是可重复读,那么在线程1的对数据库操作还没有提交的情况下线程2已经读取了数据库,此时就会读到线程1读取到的还没有被线程1修改的库存数据,当线程2提交的时候就会直接覆盖线程1的修改结果,导致线程1的更新操作全部丢失,发生超卖现象,出现线程安全问题,根本原因是mysql的默认隔离级别是可重复读Repeatable_Read以及JVM提供的锁锁不住AOP实现的由@Transactional在方法开始前开启锁,在方法结束后再提交事务,在释放锁和提交事务期间其他线程就可能读取到还没有被提交的旧数据🔎:一般数据库的事务隔离级别会设置为

RC【读已提交】和RR【可重复读】,但是这两种隔离级别都是读取已经提交后的数据

集群部署下JVM本地锁失效:JVM本地锁在服务使用集群部署时操作数据库或外置缓存共享数据时也会导致锁失效,原因类似于Ioc组件在多例模式下锁组件本身或者可重入锁是非静态成员变量时锁失效的原因,根本原因还是允许多个线程同时对共享数据进行写操作;使用两台运行实例,使用nginx做负载均衡,吞吐量略微提升至610,发生线程安全问题,出现超卖现象;单台nginx只负载一台运行实例,吞吐量为493,相较于直连运行实例性能稍降降的不多

只使用一条SQL

业务逻辑:

整个方法所有对数据库的增删改查操作都只使用一条SQL,就能避免加事务发生锁失效;

同时因为mysql内部使用悲观锁来保证一条SQL执行的原子性,因此即使是集群部署环境下,也能保证多个线程对数据库中同一个共享数据的线程安全问题;

因为mysql内部保证了一条SQL语句的原子性,因此方法连JVM的锁都不用加

测试

测试环境:

1️⃣:100个用户线程,1s内每个用户线程发起50次扣减库存请求,总共发起5000次,场景为请求连接nginx负载均衡两个运行实例操作虚拟机上的同一个数据库的同一个共享数据,查询数据库库存和更新数据库库存两条SQL简化为一条SQL

update db_stock set count=count-#{count} where product_code=#{product_no} and count >= #{count}2️⃣:在1️⃣的环境基础上再开启服务组件的多例模式

3️⃣:在1️⃣的环境基础上在服务中使用

@Transactional注解手动开启事务

测试结果:

1️⃣:测试1的吞吐量为1953,所有库存扣减请求全部成功,数据库库存被正确减为0

2️⃣:测试2的吞吐量为2224,所有库存扣减请求全部成功,数据库库存被正确减为0

3️⃣:测试3的吞吐量为1850,所有库存扣减请求全部成功,数据库库存被正确减为0

结果分析:一条SQL因为mysql内部加了悲观锁,因此服务中不需要加锁,不需要加事务,集群下也能保证数据库共享数据的操作原子性,性能提升非常可观;不仅能满足集群部署无锁并发线程安全性,还不需要加事务[1],而且在服务组件单例或者多例模式下都能保证共享数据的并发线程安全,不管是锁、事务还是多例都能可观影响系统的并发性能

解决方案优缺点

优点

能显著提升系统的并发性能,完美解决JVM本地锁三种难以避免的失效场景,还能避免使用锁,事务,多例模式下也是并发线程安全的

缺点

Mysql中的锁范围问题,mysql中会根据SQL语句调整锁的范围,如果是使用的表锁就会锁整张表,在并发业务下这种表锁是不可接受的,需要使用更细腻的行级锁来锁操作涉及的相关记录

很难应对复杂的业务场景,比如数据库中经常存在一个商品在多个仓库都有库存的情况,现实业务中往往存在一个仓库无货但是可以从其他仓库调货的情况,但是要使用数据库来做这种业务逻辑判断使用一条SQL实现是比较困难的,对复杂业务很不友好

也因为一条SQL的限制,很难记录共享数据变化前后的准确状态输出到日志中

Mysql悲观锁

使用一条SQL来通过mysql保证SQL执行的原子性,会有很难控制SQL语句使用行级锁,导致锁表大幅降低mysql表的查询效率的问题,同时一条sql很难写出复杂的业务逻辑,很难记录数据变化前后状态

如果我们能通过

select...for update查询共享数据的同时使用行级锁锁住表中对应的记录,那么就能保证锁的范围足够小,不影响同一张表其他记录的并行操作,同时利用数据库的锁来保证同一个线程对同一条记录一系列操作的原子性,还可以通过服务器来对数据进行复杂的业务逻辑判断,这一切都源于给select语句加了for update后缀来让查询操作也会导致对对应的记录上锁【这里的行级锁也要满足悲观锁使用行级锁的要求,但是因为这是单条查询语句,行级锁的满足条件比较容易控制】

业务逻辑:

给整个更新数据库的业务方法添加

@Transactional注解添加手动事务使用SQL语句

select * from db_stock where product_code=#{productCode} for update查询库存表所有商品编号为productCode的商品库存记录,并给所有查询出的记录上行级锁,查询出商品所在所有仓库以后,实际开发中对选用哪一个仓库是要经过很复杂的判断的,比如距离远近、是否还有货等等业务逻辑进行判断, 这里简单地只判断库存数量是否足够,

选中仓库就扣减对应的库存数量

测试

测试环境:

1️⃣:100个用户线程,1s内每个用户线程发起50次扣减库存请求,总共发起5000次,场景为请求连接nginx负载均衡两个运行实例操作虚拟机上的同一个数据库的同一个共享数据,使用手动事务,用select ... for update给所有可能操作的记录上行级锁,用后端服务来完成复杂逻辑的运算

测试结果:

1️⃣:测试1的吞吐量为600,所有库存扣减请求全部成功,数据库库存被正确减为0【这里老师简化了仓库选择逻辑,直接扣除第一个仓库5000次库存的】

结果分析:

1️⃣:使用mysql的行级锁的并发性能比JVM本地锁稍微好一点,但是比单条SQL差很多,因为此前是锁一条SQL,一个锁周期内服务器只会和数据库做一次交互,此时为了复杂业务逻辑使用行级锁和手动事务,一个锁周期内服务器会多次和数据库交互

解决方案优缺点

优点:

相比于一条sql能处理复杂的业务逻辑,可以获取实时的数据进行分析,可以使用代码自己写业务逻辑,也可以使用第三方框架或者大数据框架来对数据进行分析,相比于一条sql获取处理数据更灵活、功能强大的多;行级锁也更好控制

缺点:

mysql的悲观锁性能即使是行级锁并发性能只是比JVM本地锁略高,比一条sql的性能要低的多

mysql的悲观锁同样存在死锁现象,死锁发生在两个客户端都开启了事务,且都想对对方已经上锁的记录进行上锁,注意,任何客户端都能同时开启事务并尝试对已经上锁的记录加锁,并发情况下容易引起死锁问题,注意Mysql发生死锁会报错DeadLock

一旦表中有一个地方使用了

select...for update,其他业务逻辑不能使用普通的select来做业务避免出现并发性的问题❓:这个存疑,记录被锁住了,其他线程还能操作吗?还是说使用了

select...for update如果其他不使用for update上锁的操作不会等待锁会直接失败?🔑:明白了,是因为虽然线程1使用

select...for update上锁了,但是其他业务线程2如果使用普通的select,select操作不会被阻塞,只有更新操作会被阻塞【类似CopyOnWriteArrayList的读写并发】,但是如果其他业务将还没提交的数据读取到,在处理期间上锁的原业务已经提交了,此时做出的更改就是基于线程1上锁前的数据,而非线程1提交后的数据,此时多业务对共享数据的更新操作就会出现线程安全问题,因此使用select...for update所有表下的业务都得使用select...for update

Mysql乐观锁

Mysql乐观锁需要基于时间戳或者version版本号加上CAS机制来实现,但是mysql底层没有对CAS的实现,需要我们通过SQL语句来实现

业务逻辑

在要使用乐观锁的表中添加字段时间戳或者版本号,时间戳只需要使用当前最新时间即可,如果应用程序的时间戳比表中的时间戳旧或者不同,说明在应用程序处理期间发生了更新操作,就需要拿着新值对应用程序进行重试,此时数据库返回的结果是更新操作影响的行数是0,因为时间戳或者版本号对不上了,此时再次完整执行业务方法直到更新记录条数为1的情况下说明操作是线程安全的,jdbc的update相关方法的返回值就是本次更新影响的记录条数【Mybatis和MP中的也是一样的】,老师的重试使用的递归,后面测试两个服务都发生了栈内存溢出

更新成功需要把时间戳改成最后更新的时间,sql应该满足

update 表名 set 目标字段=具体值,时间戳=当前系统时间 where 条件字段=具体值 and 时间戳=应用程序提前获取的时间戳使用版本号和使用时间戳的逻辑是相同的,只是版本号要控制像时间戳一样单增,使用时间戳有个问题是时间精度的问题,如果只精确到毫秒时间间隔可能太短,这个还需要进行验证,并没有可靠的案例支持,使用版本号不存在这方面顾虑,

update 表名 set 目标字段=具体值,版本号=版本号+1 where 条件字段=具体值 and 版本号=应用程序提前获取的版本号

测试

测试环境:

1️⃣:100个用户线程,1s内每个用户线程发起50次扣减库存请求,总共发起5000次,场景为请求连接nginx负载均衡两个运行实例操作虚拟机上的同一个数据库的同一个共享数据,使用手动事务,用版本号字段作为乐观锁状态位,在mysql中一行sql保证查询版本号和更新版本号的原子性,在应用程序中实现cas操作失败无锁重试,在方法上添加了事务注解,重试递归调用了同一个方法

2️⃣:100个用户线程,1s内每个用户线程发起50次扣减库存请求,总共发起5000次,场景为请求连接nginx负载均衡两个运行实例操作虚拟机上的同一个数据库的同一个共享数据,使用手动事务,用版本号字段作为乐观锁状态位,在mysql中一行sql保证查询版本号和更新版本号的原子性,在应用程序中实现cas操作失败无锁重试,在方法上移除事务注解,仍然使用递归调用方法,但是每次尝试

sleep(20)阻塞睡眠20ms

测试结果

1️⃣:吞吐量48,错误率飙升至68%,两个服务都出现栈内存溢出,不断报错,最后抛出异常

SQLTransientConnectionException数据库连接超时异常2️⃣:吞吐量229,且吞吐量越来越小,所有库存扣减请求全部成功,数据库库存被正确减为0

结果分析

1️⃣:无锁并发重试递归调用方法存在栈内存溢出的风险,而且并发度越高,竞争越激烈,栈内存溢出风险也越高;此外方法内进行CAS无锁重试,如果竞争太激烈更新失败会导致一直在重试,但是加了事务注解手动控制事务,在事务未提交以前,数据库的DML操作会给对应的记录加行级锁或者给整个表加表锁,此时后面的重试发起的sql操作是被阻塞等待的,根本不能成功,阻塞超过默认30s就会报SQL连接超时异常,把手动事务删掉,自动事务只会加在单条DML操作上,执行失败悲观锁会立即释放掉,因此重试时不会发生阻塞等待的问题;至于栈内存溢出是递归调用方法将方法加载到栈内存导致的,这里老师的解决方法是每次重试都间隔20ms,这特么也有点离谱,都间隔20ms也是并发啊,感觉使用do...while比较合理,不去循环加载方法区代码,老师这里只是减少了对递归方法的调用次数来减少栈内存溢出的概率,感觉不是很可靠

2️⃣:吞吐量越来越小是因为竞争越来越激烈,在不加事务注解对重试进行阻塞,对重试间隔控制在20ms的递归方法调用的情况下所有请求都成功,数据库也不会发生线程安全问题,这种乐观锁重试大量无用的对数据库访问严重影响系统性能,效果甚至不如JVM本地锁

解决方案优缺点

优点

乐观锁不会导致死锁,但是悲观锁是有一定概率导致死锁的

缺点

高并发情况下,性能极低,因为存在大量的重试访问数据库

乐观锁如果使用无序改动数据比如上面的库存数据作为判断是否可以进行CAS操作的判据就会有ABA问题,ABA问题即,在正式进行cas操作前,cas操作虽然成功,但是在获取旧值和执行cas操作期间旧值如果被修改为值B和其他值,但是执行CAS操作前又改回了A值,CAS操作本身是无法判断出来的,其他业务可能使用中间值就执行其他业务了,这里使用时间戳或者版本号单增不会出现这个问题

读写分离情况下可能导致乐观锁不可靠,读写分离一般会搭建主从集群,采用主从复制的形式,让写操作去主集群,让读取操作去从集群中读取数据

🔎:主集群发生写操作会把写操作记录到自己的binlog日志中,从集群会不停地从binlog日志中拉取日志并记录到从集群的relaylog中继日志中,从集群读取中继日志replay把主集群动作SQL重演一次,对从集群执行相同的写操作,这个过程延迟比较大,记录binlog日志、将binlog读取出来发送给从集群、写入relay日志,从relay日志读取进行replay一共四次IO外加一次网络IO导致延迟比较大,因此主从分离系统同步的延迟就较大

🔎:主从分离在高并发情况下就非常容易导致主集群中写操作已经发生,但是从集群还没有同步完成,导致读取不到已经写入主集群的新数据,此时使用乐观锁就不合适,本来更新操作已经发生,但是因为从集群有延迟,cas操作读取从集群数据,但是因为延迟读取不到新值只能读到旧值,导致CAS操作成功,丢失上一次修改,乐观锁失去了作用

Mysql悲观锁范围

概念

思考mysql的悲观锁默认是行锁还是表锁

测试

测试环境

1️⃣:两个mysql本地客户端操作同一个mysql数据库,在客户端1开始事务,使用更新语句

update db_stock set count=count-1 where product_code='1001' and count>=0;更新数据库数据,然后客户端2使用更新语句update db_stock set count=count-1 where id=3;

测试结果

1️⃣:客户端1开启事务执行更新语句后,客户端2执行更新语句更新相同表与客户端1更新数据不相关的记录,客户端2进入阻塞等待,等待客户端1

结果分析

1️⃣:mysql客户端的事务默认是锁整张表,是表锁。一次更新操作期间别的SQL是无法对同一张表的任何数据进行操作的;mysql中悲观锁使用行级锁的条件是数据的查询或者更新条件必须是索引字段[1],同时查询或者更新条件必须是具体值,如果是模糊查询就会导致索引失效或者定位条件使用字段!=具体值,这两种情况悲观锁还是会使用表级锁,像=和in都会使用行级锁

备注

mysql手动事务需要使用

begin;开始事务才会使用对应的锁来实现在提交事务commit;前锁住数据库中正在被操作的目标记录,注意这期间使用查询SQL是不会给记录上锁的,只有写操作和select...for update才会给对应的记录或者整张表上锁,select...for update上行级锁也遵循上面结果分析的规则;应用中加@Transactional注解也是使用手动事务,相当于mysql中使用手动事务;不使用手动事务的情况下mysql会对每行sql操作使用自动事务

Redis

数据场景

共享数据存在于Redis数据库中,多个线程在一个方法中并发对Redis中的共享数据进行先查后改操作,修改操作为对当前数据减1

测试

测试环境:

1️⃣:100个用户线程,1s内每个用户线程发起50次扣减库存请求,总共发起5000次,场景为请求连接nginx负载均衡两个运行实例操作虚拟机上的同一个Redis数据库的同一个共享数据,没有任何锁或者保护线程安全措施

2️⃣:相同条件再测试一次

测试结果:

1️⃣:吞吐量2047,5000次扣减操作全部成功,但是Redis中库存数据应从5000减至0,实际是3704,出现超卖现象

2️⃣:吞吐量3268,5000次扣减操作全部成功,但是Redis中库存数据应从5000减至0,实际是3702,出现超卖现象

结果分析

1️⃣:出现线程安全问题,第二次测试的吞吐量相较于第一次性能提升非常大,这是因为第一次运行系统进行了预热

解决方法

JVM本地锁

在单机、单例模式下使用JVM本地锁是线程安全的,这种锁性能一般,使用方法和缺陷和共享数据在Mysql的情况下是一致的,参考Mysql解决方法中的Synchronized和ReentrantLock即可,只能单机用,限制很大

Redis乐观锁

使用Redis的

watch、multi、exec这套指令配合Redis事务来实现redis中的乐观锁操作,这种方式比较麻烦,而且可靠性较差

Redis事务

watch key [key...]可以监控一个或者多个列举变量的变量值,搭配multi和exec一起使用,Redis的事务提交是一旦在开启事务multi还没提交执行期间,如果watch指令监听的变量被其他客户端更改了,本次开启事务还未提交exec的指令将全部作废无法提交,exec指令执行会返回nil,会取消事务的执行RedisTemplate对象和StringRedisTemplate对象都有对应的watch(key)、watch(keys)、multi()、exec()方法,但是想像在客户端中使用指令一样使用这些方法是不行的,运行方法会直接报错RedisCommandExecutionExceptionRedis指令执行异常,抛异常的原因是服务器端使用这几个指令的方法不对,不能像直接在redis-cli中使用指令一样使用这几个方法,需要使用redisTemplate.execute(SessionCallback<T> session)redisTemplate.execute(SessionCallback<T> session)中的SessionCallback<T>是一个函数式接口,在该接口的注释中标明允许替代用multi/discard/exec/watch/unwatch命令来使用事务,在服务端必须通过该对象来使用事务相关的指令,弹幕说是因为要绑定会话连接和当前线程;使用redisTemplate.execute(SessionCallback<T> session)方法需要匿名实现函数式接口SessionCallback<T>,需要重写其中的抽象方法execute(RedisCallback<T> action)并在该方法中调用RedisTemplate对象和StringRedisTemplate对象对应的watch(key)、watch(keys)、multi()、exec()方法,但是不推荐直接通过RedisTemplate对象和StringRedisTemplate对象对这些方法进行调用,因为抽象方法的传参RedisCallback<T>是一个接口,RedisTemplate是其实现类,而StringRedisTemplate是RedisTemplate的子类,因此实际上该抽象方法传参就是容器组件中的StringRedisTemplate,直接通过该参数action来调用Redis事务相关的方法watch(key)、watch(keys)、multi()、exec()本地客户端用法

【redis-cli客户端1】

x127.0.0.1:6379> set stock 3704OK127.0.0.1:6379> watch stockOK127.0.0.1:6379> get stock"3704"127.0.0.1:6379> multiOK#在执行下一步前在客户端2执行更新stock的方法127.0.0.1:6379> set stock 3703QUEUED127.0.0.1:6379> exec(nil)127.0.0.1:6379> get stock"3000"#演示没有其他客户端干扰情况下的事务正常执行127.0.0.1:6379> watch stockOK127.0.0.1:6379> get stock"3000"127.0.0.1:6379> multiOK127.0.0.1:6379> set stock 2999QUEUED127.0.0.1:6379> execOK127.0.0.1:6379> get stock"2999"【redis-cli客户端2】

xxxxxxxxxx127.0.0.1:6379> set stock 3000在服务端使用Redis事务的代码正确示例

xxxxxxxxxxpublic void deduct(){redisTemplate.execute(new SessionCallback<Object>(){public Object execute(RedisOperations operations) throws DataAcessException{//watchoperations.watch("stock");//查询库存数据String stock = operations.opsForValue().get("stock").toString();//判断库存数据是否充足并扣减库存if(stock != null && stock.length() != 0){Integer stock = Integer.valueOf(stock);if(stock > 0){//multioperations.multi();operations.opsForValue().set("stock",String.valueOf(--stock));//exec执行事务operations.exec();//乐观锁更改失败重试,执行事务的返回结果集为空,则代表减库存失败,需要重试if(exec == null || exec.size() == 0){try{//防递归调用爆栈的,但是这个写法感觉很呆,用do while更优雅,老师说具体睡眠时间看机器性能,如果服务器性能不行或者redis机器性能不行,并发量太高栈或者redis都可能出问题Thread.sleep(40);deduct();}catch(InterruptedException e){e.printStackTrace();}}//执行成功需要返回exec对象给execute方法return exec;}}return null;}});}【错误示例】

不要直接在自定义方法中使用

watch、multi和exec方法,这种调用方式会直接在服务端抛RedisCommandExecutionExceptionRedis指令执行异常

xxxxxxxxxxpublic void deduct(){//watchstringRedisTemplate.watch("stock");//查询库存数据String stock = stringRedisTemplate.opsForValue().get("stock").toString();//判断库存数据是否充足并扣减库存if(stock != null && stock.length() != 0){Integer stock = Integer.valueOf(stock);if(stock > 0){//multistringRedisTemplate.multi();stringRedisTemplate.opsForValue().set("stock",String.valueOf(--stock));//execstringRedisTemplate.exec();}}}

测试

测试环境:

1️⃣:100个用户线程,1s内每个用户线程发起50次扣减库存请求,总共发起5000次,场景为请求连接nginx负载均衡两个运行实例操作虚拟机上的同一个Redis数据库的同一个共享数据,使用指令

watch、multi、exec来实现乐观锁控制多线程并发安全

测试结果:

1️⃣:吞吐量370,5000次扣减操作全部成功,Redis中库存数据应从5000减至0,实际是0,没有出现线程安全问题

结果分析

1️⃣:Redis乐观锁能够解决并发线程安全问题,但是性能相较无锁情况下损失非常高,从原来的3000直接降成370

解决方案优缺点

缺点:

Redis乐观锁的性能低,使用Jedis客户端能稍微提高性能,但是性能损耗依然很大,因此不推荐使用redis乐观锁

使用Redis乐观锁过程中可能因为机器性能问题出现连接不够用的情况导致乐观锁失效

基于Redis实现分布式锁

基于Redis的分布式锁实现是依靠Redis中的

setnx命令和del命令🔎:

setnx <key> <value>只有在<key>不存在时才能添加指定的键值对,如果键值对已存在则不能添加键值对并返回0,不存在相同的<key>则成功添加键值对并返回1;像set <key> <value>这种命令如果已经存在相同的<key>会直接将<value>用新值覆盖🔎:分布式锁的原理是假如有100个并发请求要去更改一个key对应value的状态来获取锁,只有一个请求能成功更改状态并获取到锁来操作共享资源,当操作共享资源结束以后通过指令

del直接将对应key的键值对删掉来释放锁,这样其他请求就能再次通过指令setnx <key> <value>来获取分布式锁,竞争锁失败的请求就让其有间隔时间地递归或者循环执行setnx <key> <value>来重试获取分布式锁,直到返回值为1;或者像类似重建缓存这种只需要单个请求执行的操作,当缓存重建好以后直接让其他请求放弃重试即可

操作Redis获取分布式锁以及获取锁失败的等待重试逻辑还是通过后端服务器的业务代码远程操作Redis实现

1️⃣:在业务方法执行前获取分布式锁,在finally语句块中进行解锁,避免出现异常锁无法释放导致其他请求线程无法获取指定分布式锁

🔎:

redisTemplate.opsForValue()没有setnx方法,取而代之的是setIfAbsent方法,表示如果键值对不存在才存入键值对,与之作用相反的方法是setIfPresent(key,value),表示只有当redis中存在对应的key才去覆盖对应键值对的value值🔎:注意

setIfAbsent方法在Redis中返回的是1或者0,该方法将返回值处理成返回1为true表示获取锁成功,返回0为false表示获取锁失败🔎:

redisTemplate.opsForValue()没有del方法,对应的是delete方法,上了锁一定要删掉,否则必然出现死锁现象

基础实现

只考虑基于Redis的原子性的setnx实现上锁和del实现释放锁,

不考虑获取锁的重试间隔对系统性能影响【重试竞争太激烈或者重试间隔时间太长都不利于提高系统性能】

不考虑服务器宕机导致锁无法释放进而死锁的问题【给键值对设置有效时间来避免服务器以外宕机无法释放锁导致死锁】

不考虑获取锁和设置过期时间的两步操作的原子性问题【获取锁到设置过期时间期间服务器宕机有效时间没设置上也会导致死锁,使用完整的set指令可以实现原子性和setnx的功能】

不考虑设置有效时间导致的锁提前释放后续代码裸奔【锁自动续期】,在锁提前失效导致其他线程应该阻塞结果提前错误获取锁,当前线程上的锁被其他线程通过key删除键值对释放的问题【用uuid做当前线程上锁解锁同一把锁的唯一标识】

不考虑当前线程判断自己上的锁和删除锁两步操作的原子性【Redis没有删除前对键值对判断的一条指令,要保证原子性需要使用lua】

不考虑不可重入导致的线程死锁问题以及uuid作为锁释放重入标识的局限性

获取分布式锁的服务端代码示例

递归重试代码示例

xxxxxxxxxxpublic class StockService {private StockMapper stockMapper;private StringRedisTemplate redisTemplate;public void deduct() {// 加锁setnx// redisTemplate.opsForValue()没有setnx方法,取而代之的是setIfAbsent方法,表示如果键值对不存在才存入键值对,与之作用相反的方法是setIfPresent(key,value),表示只有当redis中存在对应的key才去覆盖对应键值对的value值// 注意setIfAbsent方法在Redis中返回的是1或者0,该方法将返回值处理成返回1为true表示获取锁成功,返回0为false表示获取锁失败Boolean lock = this.redisTemplate.opsForValue().setIfAbsent("lock", "111");// 获取锁失败重试:递归调用整个业务方法,注意这里是递归调用的整个业务方法,那么一定要限制只有获取锁成功才能去执行业务方法,否则方法直接执行结束;不然如果获取锁成不成功都会去反复执行业务方法,只要逻辑清晰这种问题一般不会发生,写在这里只是给自己提一个醒if (!lock){try {Thread.sleep(50);this.deduct();} catch (InterruptedException e) {e.printStackTrace();}} else {try {// 1. 查询库存信息String stock = redisTemplate.opsForValue().get("stock").toString();// 2. 判断库存是否充足if (stock != null && stock.length() != 0) {Integer st = Integer.valueOf(stock);if (st > 0) {// 3.扣减库存redisTemplate.opsForValue().set("stock", String.valueOf(--st));}}} finally {// 解锁// redisTemplate.opsForValue()没有del方法,对应的是delete方法this.redisTemplate.delete("lock");}}}}循环重试代码示例

xxxxxxxxxxpublic class StockService {private StockMapper stockMapper;private StringRedisTemplate redisTemplate;public void deduct() {//循环重试获取锁while (!redisTemplate.opsForValue().setIfAbsent("lock", "111")){try {Thread.sleep(40);} catch (InterruptedException e) {e.printStackTrace();}}try {// 1. 查询库存信息String stock = redisTemplate.opsForValue().get("stock").toString();// 2. 判断库存是否充足if (stock != null && stock.length() != 0) {Integer st = Integer.valueOf(stock);if (st > 0) {// 3.扣减库存redisTemplate.opsForValue().set("stock", String.valueOf(--st));}}} finally {// 解锁// redisTemplate.opsForValue()没有del方法,对应的是delete方法redisTemplate.delete("lock");}}}测试

测试环境:

1️⃣:100个用户线程,1s内每个用户线程发起50次扣减库存请求,总共发起5000次,场景为请求连接nginx负载均衡两个运行实例操作虚拟机上的同一个Redis数据库的同一个共享数据,使用上诉递归重试代码示例实现的基于Redis的乐观锁对库存数量5000进行单次扣减1,累计5000次扣减请求

2️⃣:100个用户线程,1s内每个用户线程发起50次扣减库存请求,总共发起5000次,场景为请求连接nginx负载均衡两个运行实例操作虚拟机上的同一个Redis数据库的同一个共享数据,使用上诉循环重试代码示例实现的基于Redis的乐观锁对库存数量5000进行单次扣减1,累计5000次扣减请求

测试结果:

1️⃣:吞吐量549,5000次扣减操作全部成功,Redis中库存数据应从5000减至0,实际是0,没有出现线程安全问题

2️⃣:吞吐量605,5000次扣减操作全部成功,Redis中库存数据应从5000减至0,实际是0,没有出现线程安全问题

结果分析:

1️⃣:吞吐量和JVM本地锁操作mysql中的共享数据差不多,效率还是低,感觉循环重试的网络开销才是影响性能的主要大头,老师自己都说递归调用这种行为不好存在爆栈风险,此前mysql的递归调用是没有改的,最好还是使用循环来重试获取锁

2️⃣:基于Redis乐观锁的实现循环调用的性能比递归调用的性能略高

防宕机死锁

给键值对设置过期时间防止服务器宕机锁无法释放导致的死锁

使用基于Redis实现的乐观分布式锁的关注要点

1️⃣:不管是循环重试还是递归重试获取锁,都要控制重试的时间间隔,否则连接资源开销太大可能会压垮服务器,但是重试间隔时间太久也会压低系统性能,这个取间隔时间的标准要好好关注一下;

🔎:老师对睡眠时间的理解是设置合适的睡眠时间能降低线程对锁的整体竞争压力,反而能提高使用乐观锁的系统性能,但是没有提及如何选取一个合适的间隔时间

❓:而且没有考虑最大重试时间或者次数的问题,一旦出现问题根本无法获取锁,所有请求就会一直进行递归或者循环重试,实际应用中都需要根据业务需求在原理的基础上重新设计

2️⃣:此外下面的实现都是所有线程获取不到锁都会重试直到获取锁,这种方式适合解决超卖应用场景让每个扣减请求都成功正确扣减;对于类似重建分布式缓存这种场景只需要重建一次缓存,其余抢不到锁的请求阻塞等待,重建失败其余等待请求再次重试,缓存重建成功其余请求不再重试需要在该原理的基础上进一步修改,这个实际上应该在业务方法中自定义获取不到锁的行为,循环重试和递归重试都是业务方法的行为,分布式锁设计不需要考虑这一点,直接在业务方法中通过双重检查锁实现一次构建缓存即可

3️⃣:这种基于Redis实现的分布式锁还要注意防死锁的发生,因为锁是从第三方获取并通过指令远程操纵第三方对锁进行释放的,如果服务器【服务器此时也可以叫做redis客户端程序】在获取锁执行业务代码期间宕机了,即使释放锁的操作写在finally语句块中也是无法被执行的【即使该服务器恢复了代码也无法继续向下执行释放锁的代码】,那么此时锁就变成死锁永远得不到释放了,要解决这个问题可以给锁对应的键值对设置一个合适的过期时间;

🔎:Redis中提供指令

EXPIRE <key> <seconds>来为指定key的键值对设置秒级别的过期时间,还提供了指令PEXPIRE <key> <milliseconds>来为指定key的键值对设置毫秒级别的过期时间,使用指令ttl <key>能查看锁对应键值对的过期时间【键值对过期以后ttl <key>指令的返回值为-2】。锁一旦过期就会自动被释放掉🔎:给锁相关键值对设置有效时间的代码不能放在获取锁以后分步来执行,因为可能会发生第一次执行获取锁时,客户端程序还没来得及给锁对应键值对设置有效时间就宕机了,那么在这种情况下仍然会发生死锁现象,需要保证获取锁和设置过期时间操作的原子性,此时我们可以考虑使用复杂的set指令来通过一条指令同时实现获取锁和设置过期时间的目标;redis和mysql一样能保证一条指令执行的原子性

🔎:Redis中set指令的完整格式为

set <key> <value> [Ex seconds] [Px milliseconds] [NX|XX],Ex表示设置秒级别的过期时间,Px表示设置毫秒级别的过期时间,NX表示当键值对不存在时该指令能成功执行,XX表示当键值对存在时该指令才能成功执行覆盖对应key的value值;指令set lock 111 ex 20 nx的意思是当redis中以lock作为key的键值对不存在时将键值对<"lock","111">存入redis中并设置键值对的过期时间为20s;这条指令对应封装在setIfAbsent(String key,String value)的重载方法setIfAbsent(String key,String value,long timeout,TimeUnit unit)中,循环重试加锁并原子性给锁设置有效时间的完整代码示例如下所示:xxxxxxxxxxpublic class StockService {private StockMapper stockMapper;private StringRedisTemplate redisTemplate;public void deduct() {//循环重试获取锁while (!redisTemplate.opsForValue().setIfAbsent("lock","111",20,TimeUnit.SECONDS)){try {Thread.sleep(40);} catch (InterruptedException e) {e.printStackTrace();}}try {// 1. 查询库存信息String stock = redisTemplate.opsForValue().get("stock").toString();// 2. 判断库存是否充足if (stock != null && stock.length() != 0) {Integer st = Integer.valueOf(stock);if (st > 0) {// 3.扣减库存redisTemplate.opsForValue().set("stock", String.valueOf(--st));}}} finally {// 解锁// redisTemplate.opsForValue()没有del方法,对应的是delete方法redisTemplate.delete("lock");}}}🔎:设置了过期时间也可能带来一系列问题,第一个问题是假如线程1获取了锁且给锁上了有效时间,但是线程1可能因为其他原因一直被阻塞或者锁的过期时间太短【比如锁的有效时间是3s,但是执行业务方法就需要5s或者重试次数太多,可能执行过程中redis中的锁就被自动释放掉了】,等到锁过期了继续执行后续的业务代码,此时线程1就处于无锁裸奔的情况,有可能会发生线程安全问题;除此以外后续上锁的请求线程如线程2上的锁还有可能直接被前一个提前自动释放锁的线程1执行完业务方法调用delete方法直接手动将线程1的锁给释放掉了,导致后续的连续出错,而且后续请求执行时间大于锁的有效时间也会继续自动释放,最终所有请求的执行都处于无锁裸奔状态,此时有锁和无锁就没啥区别了,相当于锁失效;此时有两个问题,第一个是一个线程可能会去释放另外一个线程的锁,第二个问题是锁可能会在业务方法执行结束前提前失效,因此还需要实现防非当前线程释放当前线程的锁,以及业务方法没执行结束锁过期让锁自动续期

正确释放锁

以UUID作为锁的唯一标识让当前上锁的线程只释放自己上的锁,此外还要用lua脚本保证检查uuid和释放锁两步操作的原子性

防止非当前线程释放当前线程的锁,可以给当前线程上的锁加一个唯一标识,要实现每个线程锁唯一还要被所有线程抢占同一把锁可以让key相同,让对应的value作为当前线程的唯一标识【可以使用UUID作为该标识】;把释放锁的逻辑改成释放锁前先去判断一下锁是否是当前线程获取锁时的value,value只有和自己锁时相同才能由当前线程去释放锁,如果不相同则无需再释放锁,示例代码如下

xxxxxxxxxxpublic class StockService {private StockMapper stockMapper;private StringRedisTemplate redisTemplate;public void deduct() {String uuid = UUID.randomUUID().toString();//循环重试获取锁while (!redisTemplate.opsForValue().setIfAbsent("lock",uuid,20,TimeUnit.SECONDS)){try {Thread.sleep(40);} catch (InterruptedException e) {e.printStackTrace();}}try {// 1. 查询库存信息String stock = redisTemplate.opsForValue().get("stock").toString();// 2. 判断库存是否充足if (stock != null && stock.length() != 0) {Integer st = Integer.valueOf(stock);if (st > 0) {// 3.扣减库存redisTemplate.opsForValue().set("stock", String.valueOf(--st));}}} finally {// 解锁// 判断value是否是自己设置的value值,这个StringUtils老师使用的是common-lang3中的StingUtils工具类if(StringUtils.equals(redisTemplate.opsForValue.get("lock"),uuid)){// redisTemplate.opsForValue()没有del方法,对应的是delete方法redisTemplate.delete("lock");}}}}🔎:上述代码还是存在问题,因为没有保证删除该锁和判断锁的value是自己设置的两个过程是原子性的,在获取锁和删除锁期间还是有可能锁过期其他线程上锁然后被当前线程调用delete方法删除其他线程上的锁,导致下一个请求无锁裸奔,可能出现并发线程安全问题,Redis中没有指令既能判断键值对还能同时删除对应键值对的,只能借助Lua脚本来进行实现

使用Lua脚本来保证上述释放锁查询判断value值和当前线程获取锁生成的value值相同并删除对应锁两个操作的原子性

使用lua脚本可以保证Redis多条指令原子性的原理是Redis客户端程序通过lua脚本把多个Redis指令一次性发送给Redis服务器,那么这些指令就不会被其他客户端指令打断。Redis的单线程设计也会保证脚本以原子性的方式执行即当某个脚本正在运行的时候,不会有其他脚本或Redis命令被执行。关于Lua语言的语法和Redis中使用Lua脚本执行Redis命令的知识请查看后端--Lua,这里只列举对应的java程序实现

RedisTemplate或者StringRedisTemplate对象中的execute方法有一个重载方法execute(RedisScript<T> script,List<String>) keys,Object... args)可以传递脚本script,KEYS列表和ARVG列表🔎:

execute方法的第一个参数RedisScript类型是一个接口且非函数式接口,该接口只有一个实现DefaultRedisScript,因此第一个参数需要通过构造方法传参不带换行的lua脚本即scriptnew DefaultRedisScript(script)将lua脚本封装成DefaultRedisScript,但是特别注意,如果使用该构造方法new DefaultRedisScript(script)封装lua脚本运行会直接抛异常UnsupportedOperationException,必须使用重载的双参构造方法指定返回值类型即new DefaultRedisScript(String script,Class<Object> resultType)指定返回值类型如new DefaultRedisScript(script,Boolean.class),这个返回值就是lua脚本输出在redis-cli控制台的返回值,这个返回值类型随便瞎写也不会报错,但是不指定返回值类型下列程序运行就会直接抛异常,注意new DefaultRedisScript<>(script,Boolean.class),这个尖括号要求的也是返回值的类型,第二个参数指定了该尖括号就不需要指定了,如果指定要保证两个类型要一致

基于Redis和lua脚本实现的分布式锁的服务器端Java代码

xxxxxxxxxxpublic class StockService {private StockMapper stockMapper;private StringRedisTemplate redisTemplate;public void deduct() {String uuid = UUID.randomUUID().toString();//循环重试获取锁while (!redisTemplate.opsForValue().setIfAbsent("lock",uuid,20,TimeUnit.SECONDS)){try {Thread.sleep(40);} catch (InterruptedException e) {e.printStackTrace();}}try {// 1. 查询库存信息String stock = redisTemplate.opsForValue().get("stock").toString();// 2. 判断库存是否充足if (stock != null && stock.length() != 0) {Integer st = Integer.valueOf(stock);if (st > 0) {// 3.扣减库存redisTemplate.opsForValue().set("stock", String.valueOf(--st));}}} finally {//解锁,只需要尝试一次,解锁成功即可,解锁失败就不管了,感觉这也不合理,应该还要拿到删除的结果或者key是否还存在来进行重试判断,防止网络故障等原因,总之没有重试机制不是很专业String script="if redis.call('get',KEYS[1]) == ARGV[1] then return redis.call('del',KEYS[1]) else return 0 end";redisTemplate.execute(new DefaultRedisScript<>(script,Boolean.class),Arrays.asList("lock"),uuid);}}}测试环境:

1️⃣:100个用户线程,1s内每个用户线程发起50次扣减库存请求,总共发起5000次,场景为请求连接nginx负载均衡两个运行实例操作虚拟机上的同一个Redis数据库的同一个共享数据,使用上诉基于Redis和lua脚本实现的分布式锁的服务器端Java代码示例实现的基于Redis的乐观锁对库存数量5000进行单次扣减1累计,使用uuid作为键值对的value,使用lua脚本来检查锁是否属于当前线程并删除键值对释放锁

测试结果

1️⃣:吞吐量650,5000次扣减操作全部成功,Redis中库存数据应从5000减至0,实际是0,没有出现线程安全问题

锁重入实现

参考JDK的可重入锁ReentrantLock的上锁解锁原理实现分布式锁的上锁解锁,用lua脚本一次提交执行和Redis单线程保证lua脚本操作的原子性,用lua脚本进行Redis操作来实现Redis多步操作组合逻辑来实现类似可重入锁的上锁逻辑和解锁逻辑

ReentrantLock原理

解决分布式锁不可重入导致死锁的问题

原理:两个方法可能都需要占有同一把锁,当一个方法1占有锁以后调用另一个方法2,此时就会发生锁重入,如果锁设计时不支持可重入,那么就会发生方法1等待方法2执行结束以后才能释放锁,但是方法2需要方法1释放锁以后才能获取锁执行,此时就会发生死锁现象,因此在必要的情况下还需要设计分布式锁的可重入来避免发生死锁,分布式锁的可重入思想可以参考ReentrantLock的锁重入设计

ReentrantLock原理:这个黑马JUC把源码讲的很清楚了,看笔记就行,这里只记录要点

🔎:ReentrantLock的默认无参构造方法是构造非公平实现的同步器,构造方法传参true是构造公平实现,传参false也是构造非公平实现,公平和非公平的区别体现在新线程是否要等队列中的节点对应线程都释放锁以后才有资格抢占锁【公平实现】还是在进入队列以前不管队列中有无节点都可以首先尝试获取锁【非公平实现】,同步器管理控制锁的行为,同步器继承抽象父类AQS,AQS是一切Java层面实现的锁【独占锁ReentrantLock、共享锁ReentrantReadWriteLock、Semaphore、CountdownLatch】的基础,AQS底层主要由int类型的state属性、int类型的waitStatus、从AQS的父类继承来的Thread类型的exclusiveOwnerThread属性和一个FIFO队列构成;AQS中线程上锁实质是多线程并发调用CompareAndSetState方法使用cas操作更改state属性的状态,在CompareAndSetState方法中调用UNSAFE类【Unsafe类可以通过类对象和属性相对于对象的内存偏移量直接对属性内存进行操作,里面提供了大量硬件级别的CAS原子性操作】的compareAndSwapInt方法,这里面的偏移量的计算在static静态代码块中,在类加载的时候就计算完毕了,Unsafe对象的获取方法上加了注解

@CallerSensitive注解,只能在JDK的源码中使用【严重怀疑这里只是说AQS中获取的unsafe对象只能被JDK使用,具体回顾一下JUC中对Unsafe类的使用】,在用户自己的项目里面是使用不了的🔎:AQS类中有2000多行代码,大部分的同步器功能都已经被实现好了,用户可以基于AQS实现自定义独占锁和共享锁,要实现独占锁需要重写AQS中的

tryAcquire(int)方法【该方法在AQS中直接抛异常,即子类不实现该方法上锁时就会直接抛UnsupportedOperationException异常】和tryRelease(int)方法;要实现共享锁需要子类重写tryAcquireShared(int)方法和tryReleaseShared(int)方法;ReentrantLock方法的同步器Sync只实现了tryRelease方法,tryAcquire方法由其非公平子类进行实现【非公平子类实现NonfairSync实际上只重写了tryAcquire方法和lock方法】ReentrantLock锁重入的最重要的逻辑是,如果state等于0就直接cas操作加锁;如果state不等于0就判断当前线程是否占有锁的线程,如果是state加1【即重入次数加1】,否则进入阻塞队列阻塞;释放锁时让state减1,判断当前线程是否是锁的持有者,判断新state值是否为0,为0表示锁解干净了,设置owner为null,将state设置为新值并返回true,后续根据true唤醒享元下一个节点;如果不为0表示锁还没释放干净,将state设置为新值并返回false

ReentrantLock方法的上锁流程

1️⃣

reentrantLock.lock():用户调用ReentrantLock的上锁方法2️⃣

nonfairSync.lock():ReentrantLock方法默认调用的是非公平实现的lock方法3️⃣

AQS.acquire():非公平实现的lock调用的是同步器的继承自抽象父类AQS的acquire方法,在AQS的acquire方法中调用了非公平实现的tryAcquire方法尝试获取锁,在tryAcquire方法执行失败的情况下执行acquireQueued(addWaiter(Node.EXCLUSIVE),arg)方法来创建获取锁失败的线程对应的节点,当AQS队列没有节点的情况下再尝试两次获取锁,如果还是获取不到,节点入AQS队列,当前线程使用LockSupport的park方法自我进行阻塞4️⃣

nonfairSync.tryAcquire():非公平实现的上锁方法tryAcquire方法又调用了从父类Sync中继承来的nonfairTryAcquire方法5️⃣

sync.nonfairTryAcquire(int acquires):acquires的值实际上为1,在该方法中获取state的值,如果state等于0使用cas操作将其改为1,如果成功表示上锁成功返回true方法结束,如果state不为0就检查当前线程是否为此前占有锁的线程,如果不是直接返回false返回进入阻塞等待的逻辑,如果是当前占有锁的线程说明发生锁重入,将state状态加1,此时也只有当前线程能运行到此处,因此这个更新state状态无需使用cas操作,重入成功直接返回true方法结束6️⃣

AQS.addWaiter(Node mode):该方法就是准备入队列前的准备方法了,首先创建一个关联当前线程的Node节点,检查AQS队列中的尾结点是否为null,如果不为null就使用cas操作将当前节点更改为尾节点,把当前节点连到尾结点上并返回node节点;如果尾结点为null说明队列中没有节点,就调用enq(node)方法,然后返回node节点7️⃣

AQS.enq(final Node node):如果尾节点为空,说明AQS队列中没有等待的线程,但是当前线程因为竞争获取不到锁仍然要入队列,进入该方法是一个死循环,此时获取尾节点检查尾节点是否为null【这一步实际上是检查AQS队列的享元是否创建,没有享元就创建享元】,如果为null就创建一个不关联任何线程的Node节点【实际上是代表当前占有锁的线程,因为后面会根据享元的waitStatus,当前占有锁的线程来判断是否要唤醒后一个节点】,如果享元不为null就会在第二次循环中将当前线程对应的节点加到享元后面,并让享元的next指向当前节点,让当前节点的prev指向享元【所以AQS板上钉钉使用了双向链表结构】 ,让节点加入队列以后返回当前节点

ReentrantLock的解锁流程

1️⃣

reentrantLock.unlock():用户调用ReentrantLock的解锁方法2️⃣

nonfairSync.release(1):ReentrantLock方法默认调用的是非公平实现的release方法,但是非公平实现中只有lock方法和tryAcquire方法,release方法也是从AQS中继承来的方法,而且release方法中的参数列表1是写死的,该方法中首先调用tryRelease(1)方法尝试解锁,解锁成功【只有包括重入的锁完全释放才会返回true】检查AQS队列的享元是否存在,存在的情况下waitStatus是否不为0,不为0就需要调用unparkSuccessor(h)方法唤醒享元的后继节点,该方法解锁成功就返回true,解锁失败就返回false3️⃣

nonfairSync.tryRelease():tryRelease方法对应基于AQS实现的独占锁的tryAcquire方法,两个方法都抛出UnsupportedOperationException异常,都需要被子类同步器重写,可重入锁的tryRelease方法是由Sync而非NonFairSync实现的,这点与tryAcquire方法不同,这是因为公平锁和非公平锁的解锁流程是相同的,但是上锁时公平锁需要检查AQS队列中是否有节点,非公平锁不需要检查而是首先进行竞争的差异导致的;tryRelease方法首先会获取state的值并在值的基础上减1,判断当前线程是否锁的占有线程,不是直接抛异常IllegalMonitorStateException,如果锁的占有者是当前线程,判断state是否等于0,如果是说明锁释放干净了将exclusiveOwnerThread设置为null,然后将state设置为新值,注意只有锁释放干净了该方法才会将exclusiveOwnerThread设置为null并返回true,只有在返回true的情况下才会去尝试唤醒享元后面的节点

可重入分布式锁

参考ReentrantLock实现非公平的分布式可重入锁的lua脚本上锁和释放锁逻辑

🔎:通过Redis中唯一的key和setnx指令来实现独占锁,通过value使用uuid作为当前线程的唯一标识,

🔎:如何在Redis中保存锁的重入状态,可以考虑在UUID后面加个计数,但是这种方式实现起来比较复杂,在Redis中有一种数据结构叫Hash,Hash是一个键值对集合,key就是正常的key,value是一个String类型的field和value的映射表,即Java中的Map,value可以有很多个键值对,哈希特别适合存储对象,类似于Java中的Map<String,Object>,很像一个对象,key就是对象比如user对象的名字,有个字段叫

age,值为20;还有个字段是银行余额balance,值为5000;即Hash可以认为是一个双层Map,也可以认为是一个对象使用命令

hset user name '柳岩'插入Hash类型的数据到Redis中,对应的要实现基于Redis分布式锁可以将锁的数据封装成hset lock uuid 锁的重入次数,即将基于Redis的分布式设计为使用hash数据类型+lua脚本+乐观锁机制

加锁实现逻辑如下,加锁、重入成功都返回1,加锁、重入失败都返回0,对应Java中的true和false

1️⃣:通过Redis指令

EXISTS <key>判断键值对是否存在线程占有锁,如果存在则返回1,不存在则返回0;2️⃣:如果返回0说明没有线程占用锁,当前线程可以直接通过Redis指令

hset <key> <field> 1获取锁;通过Redis指令expire <key> <time>为锁设置有效时间防死锁🔎:ttl为-1表示当前键值对没有设置有效时间

3️⃣:如果返回1说明有线程占用锁,当前线程使用Redis指令

HEXISTS <key> <field>判断Redis中的锁的field是否当前线程的uuid,如果是返回1,如果不是返回0;如果是当前线程的uuid,说明发生锁重入,此时使用Redis指令

hincrby <key> <field> <increment>将value值递增increment,然后使用Redis指令expire <key> <time>将锁的有效时间进行重置如果不是当前线程的uuid,说明锁已经被其他线程占有,此时线程应该进入阻塞,但是这个实现工作量太大,使用循环尝试或者递归重试加间隔时间代替,不亚于实现一个ReentrantLock,可以考虑直接在Java代码中使用ReentrantLock来阻塞唤醒,减少重试竞争

对应的lua加锁脚本

🔎:注意如果redis中没有对应的键值对,经过测试此时直接使用

hexists lock uuid 1和命令hset lock uuid 1的效果是相同的,都是将该键值对加入hset中且value值为1,故下面的lua代码可以合并简化

xxxxxxxxxxif redis.call('exists','lock') == 0 thenredis.call('hset','lock',uuid,1)redis.call('expire','lock',30)return 1elseif redis.call('hexists','lock',uuid) == 1 thenredis.call('hincrby','lock',uuid,1)redis.call('expire','lock',30)return 1elsereturn 0end【合并简化的lua代码】

🔎:lua的逻辑运算符只有

and、or、not🔎:所有参数都使用传参的KEYS列表和ARVG列表传参,增强lua代码的复用性;键值对的key用KEYS列表,uuid和有效时间用ARGV列表传递

xxxxxxxxxxif redis.call('exists',KEYS[1]) == 0 or redis.call('hexists',KEYS[1],ARGV[1]) == 1 thenredis.call('hincrby',KEYS[1],ARGV[1],1)redis.call('expire',KEYS[1],ARGV[2])return 1elsereturn 0end解锁逻辑如下,如果锁不存在lua代码中返回nil,对应java代码中的null,可以在java代码中手动抛出异常

1️⃣:使用Redis指令

hexists判断当前线程获取的锁是否存在,该指令不存在返回0,存在返回12️⃣:如果锁不存在就直接返回nil,由Java层面直接抛异常

3️⃣:如果锁存在直接使用Redis指令

hincrby <key> uuid -1将value值减1,然后判断减1后的value值是否为0,如果为0表示锁释放干净了直接使用Redis指令del <key>删除对应键值对返回1;不为0表示锁还没有释放干净,直接返回0🔎:注意指令

hincrby <key> uuid -1的返回值就是value减去1后的值

对应的lua释放锁脚本

xxxxxxxxxxif redis.call('hexists',KEYS[1],ARVG[1]) == 0 thenreturn nilelseif redis.call('hincrby',KEYS[1],ARVG[1],-1) == 0 thenreturn redis.call('del',KEYS[1])elsereturn 0end

使用Java在服务端远程操作Redis通过Redis、Lua脚本、乐观锁机制实现的可重入分布式锁

实现逻辑:

这个实现没有做基于AQS的阻塞唤醒,应该是可以在Java层面做到线程的阻塞唤醒的

创建分布式锁类

DistributedRedisLock,该类实现Lock接口,分布式锁只需要关注上锁和解锁方法,上锁方法只需要实现代参数的tryLock方法,不带参数的tryLock方法可以传参过期时间-1表示默认过期时间30s的锁,lock方法直接调用tryLock方法

🔎:要使用自动注入注解来使用IOC容器组件的类也必须纳入IOC容器的管理才行,简单点添加

@Component注解,以后使用就可以注入DistributedRedisLock直接使用,但是这样还是不够好,因为对于不同的分布式锁实现需要注入不同的组件,我们可以通过工厂设计模式来创建对应的实例对象,这样可以在工厂对象中使用IoC容器组件,分布式锁的具体实现不注入容器中,这样还能节省内存重新设计Redis中锁的键值对Hset的field字段,让uuid作为服务的标识,让获取锁时以线程id作为锁的标识,用每个服务唯一的uuid:线程id作为field字段;field字段用于解决分布式环境下的锁的可重入实现同一个线程对同一把锁多次上锁,让获取分布式锁的标准只判断指定key的HSet是否存在,如果不存在则直接上锁,如果存在则根据当前线程的id和服务的uuid是否和当前线程一致,一致说明是锁重入进入锁重入逻辑;如果不一致说明指定key的锁发生竞争,当前线程进入等待重试

🔎:这里

uuid:线程id只是用来判断是否发生锁重入,不是用来判断锁是否被占有,锁被占有的判据是key,所以不会存在因为线程的id不同导致filed字段不同导致相同的key不同的field发生锁不住的情况,即key相同,但是field不同的线程无法锁重入,对应key的HSet存在,因此上不了锁,等待重试🔎:此外,因为是以key对应的Hset作为锁,因此只要key不同,锁就不同,同一个线程要上多把锁可以根据Hset的key为区别区分不同的锁,即使这些锁的field是一样的但是他们的key不一样也是不同的锁,因此一个线程是可以上多把锁的

【基于Redis的可重入失败的分布式锁实现】

🔎:这里的上锁实现是执行lock方法首先去获取锁,但是一获取锁就去创建新的锁对象并创建新的uuid,即只要在不同方法中调用了

distributedLockClient.getRedisLock("lock")后续即使调用lock方法内部方法应该是锁重入也会因为上的是不同的锁导致锁重入失败,这是因为无法在定义方法时就确定方法调用顺序的前提下就要区分方法调用导致的锁重入使用同一把锁引起的,因此还需要在锁内部设计在获取锁时判断外层方法是否有锁;判断方法被同一个线程调用的最好的标识就是Thread的id,通过检查有没有当前线程对应的key和相同的field就知道调用者是否已经对同一把锁上锁【分布式锁实现】

xxxxxxxxxxpublic class DistributedRedisLock implements Lock {private StringRedisTemplate redisTemplate;private String lockName;private String uuid;//默认锁的有效时间private long expire = 30;//每次获取该分布式锁对象都重新创建锁对象和创建新的uuid,这是有问题的,因为在方法定义时就要获取,如果每个方法调用获取锁都重新创建锁对象对锁对象生成完全不同的uuid,此时每次获取锁上锁都是对不同的锁上锁,根本就不会发生锁重入public DistributedRedisLock(StringRedisTemplate redisTemplate, String lockName) {this.redisTemplate = redisTemplate;this.lockName = lockName;this.uuid = UUID.randomUUID().toString();}public void lock() {this.tryLock();}public void lockInterruptibly() throws InterruptedException {}public boolean tryLock() {try {return this.tryLock(-1L, TimeUnit.SECONDS);} catch (InterruptedException e) {e.printStackTrace();}return false;}/*** 加锁方法* @param time* @param unit* @return* @throws InterruptedException*/public boolean tryLock(long time, TimeUnit unit) throws InterruptedException {if (time != -1){//把过期时间都转换成秒来作为传给指令的秒参数,没指定时间就使用默认的30sthis.expire = unit.toSeconds(time);}String script = "if redis.call('exists', KEYS[1]) == 0 or redis.call('hexists', KEYS[1], ARGV[1]) == 1 " +"then " +" redis.call('hincrby', KEYS[1], ARGV[1], 1) " +" redis.call('expire', KEYS[1], ARGV[2]) " +" return 1 " +"else " +" return 0 " +"end";while (!this.redisTemplate.execute(new DefaultRedisScript<>(script, Boolean.class), Arrays.asList(lockName), uuid, String.valueOf(expire))){Thread.sleep(50);}return true;}/*** 解锁方法*/public void unlock() {String script = "if redis.call('hexists', KEYS[1], ARGV[1]) == 0 " +"then " +" return nil " +"elseif redis.call('hincrby', KEYS[1], ARGV[1], -1) == 0 " +"then " +" return redis.call('del', KEYS[1]) " +"else " +" return 0 " +"end";Long flag = this.redisTemplate.execute(new DefaultRedisScript<>(script, Long.class), Arrays.asList(lockName), uuid);if (flag == null){throw new IllegalMonitorStateException("this lock doesn't belong to you!");}}public Condition newCondition() {return null;}}【分布式锁工厂类实现】

xxxxxxxxxxpublic class DistributedLockClient {private StringRedisTemplate redisTemplate;//通过get方法实例对应的锁对象,实现锁对象的懒惰实例化,对应方法执行完锁对象也会主动销毁public DistributedRedisLock getRedisLock(String lockName){return new DistributedRedisLock(redisTemplate, lockName);}}【业务类对锁的使用】

xxxxxxxxxxpublic void deduct() {DistributedRedisLock redisLock = this.distributedLockClient.getRedisLock("lock");redisLock.lock();try {// 1. 查询库存信息String stock = redisTemplate.opsForValue().get("stock").toString();// 2. 判断库存是否充足if (stock != null && stock.length() != 0) {Integer st = Integer.valueOf(stock);if (st > 0) {// 3.扣减库存redisTemplate.opsForValue().set("stock", String.valueOf(--st));}}} finally {redisLock.unlock();}}

【基于Redis的可重入的分布式锁实现】

🔎:在上面实现的基础上更改表示锁的Redis中的HSet的filed字段,将field字段从uuid改成了uuid:线程id;让每次获取锁都获取全新的锁变成了每个服务对应一个uuid,同一个线程获取同一把锁,不同的锁通过key进行唯一标识,锁重入通过key和field字段共同标识,从而同时实现一个线程可以通过key不同上多把锁,也可以通过key和field都相同来进行锁重入,key同field不同来对要获取同一把key的锁的其他线程进行阻塞重试,用lua一次提交不可被打断和Redis单线程特性来保证对上锁和解锁操作的原子性

🔎:因为工厂类

DistributedLockClient加了@Component注解,所以是单例的,其中的uuid属性只由该工厂类构造方法创建,因此也是单例的,所以uuid属性只是作为每个服务的判断标识,不再作为判断是否同一个线程锁重入的标识,使用更好的Thread.id作为锁重入的标识,让uuid:线程id来区分具体服务的线程,没有uuid两个服务的线程id可能相等,此时再按lua的上锁解锁逻辑就会导致另一个服务的同名线程上锁可以通过锁重入逻辑进行,发生锁不住的现象,所以此处作为服务标识的uuid也是必要的【分布式锁实现】

xxxxxxxxxxpublic class DistributedRedisLock implements Lock {private StringRedisTemplate redisTemplate;private String lockName;private String uuid;private long expire = 30;public DistributedRedisLock(StringRedisTemplate redisTemplate, String lockName, String uuid) {this.redisTemplate = redisTemplate;this.lockName = lockName;this.uuid = uuid;}public void lock() {this.tryLock();}public void lockInterruptibly() throws InterruptedException {}public boolean tryLock() {try {return this.tryLock(-1L, TimeUnit.SECONDS);} catch (InterruptedException e) {e.printStackTrace();}return false;}/*** 加锁方法* @param time* @param unit* @return* @throws InterruptedException*/public boolean tryLock(long time, TimeUnit unit) throws InterruptedException {if (time != -1){this.expire = unit.toSeconds(time);}String script = "if redis.call('exists', KEYS[1]) == 0 or redis.call('hexists', KEYS[1], ARGV[1]) == 1 " +"then " +" redis.call('hincrby', KEYS[1], ARGV[1], 1) " +" redis.call('expire', KEYS[1], ARGV[2]) " +" return 1 " +"else " +" return 0 " +"end";while (!this.redisTemplate.execute(new DefaultRedisScript<>(script, Boolean.class), Arrays.asList(lockName), getId(), String.valueOf(expire))){Thread.sleep(50);}return true;}/*** 解锁方法*/public void unlock() {String script = "if redis.call('hexists', KEYS[1], ARGV[1]) == 0 " +"then " +" return nil " +"elseif redis.call('hincrby', KEYS[1], ARGV[1], -1) == 0 " +"then " +" return redis.call('del', KEYS[1]) " +"else " +" return 0 " +"end";Long flag = this.redisTemplate.execute(new DefaultRedisScript<>(script, Long.class), Arrays.asList(lockName), getId());if (flag == null){throw new IllegalMonitorStateException("this lock doesn't belong to you!");}}public Condition newCondition() {return null;}/*** 给线程拼接唯一标识* @return*/String getId(){return uuid + ":" + Thread.currentThread().getId();}}【分布式锁工厂类实现】

xxxxxxxxxxpublic class DistributedLockClient {private StringRedisTemplate redisTemplate;private String uuid;public DistributedLockClient() {this.uuid = UUID.randomUUID().toString();}public DistributedRedisLock getRedisLock(String lockName){return new DistributedRedisLock(redisTemplate, lockName, uuid);}}【业务类对锁的使用】

xxxxxxxxxxpublic void deduct() {DistributedRedisLock redisLock = this.distributedLockClient.getRedisLock("lock");redisLock.lock();try {// 1. 查询库存信息String stock = redisTemplate.opsForValue().get("stock").toString();// 2. 判断库存是否充足if (stock != null && stock.length() != 0) {Integer st = Integer.valueOf(stock);if (st > 0) {// 3.扣减库存redisTemplate.opsForValue().set("stock", String.valueOf(--st));}}} finally {redisLock.unlock();}}

测试

测试环境:

1️⃣:100个用户线程,1s内每个用户线程发起50次扣减库存请求,总共发起5000次,场景为请求连接nginx负载均衡两个运行实例操作虚拟机上的同一个Redis数据库的同一个共享数据,使用上诉基于Redis的hset和lua脚本实现的可重入失败分布式锁对库存数量5000进行单次扣减1,累计5000次扣减请求

2️⃣:在步骤1的基础上写一个获取相同分布式锁的方法1,在业务方法上锁的代码中调用方法1,让锁进行重入测试分布式锁的锁重入效果

3️⃣:100个用户线程,1s内每个用户线程发起50次扣减库存请求,总共发起5000次,场景为请求连接nginx负载均衡两个运行实例操作虚拟机上的同一个Redis数据库的同一个共享数据,使用上诉基于Redis的hset和lua脚本实现的可重入分布式锁对库存数量5000进行单次扣减1,累计5000次扣减请求

测试结果:

1️⃣:吞吐量591,5000次扣减操作全部成功,Redis中库存数据应从5000减至0,实际是0,没有出现线程安全问题

2️⃣:锁重入失败了,因为每次上锁前获取锁都是获取的不同锁,每次都要创建全新的uuid,就不可能对同一个锁第二次上锁,因此锁重入失败

3️⃣:吞吐量626,5000次扣减操作全部成功,Redis中库存数据应从5000减至0,实际是0,没有出现线程安全问题

自动续期

自动续期可以使用定时任务来实现当锁快过期的时候给锁续期,使用lua脚本保证续期多步操作如判断锁是否是当前线程占用,是的情况下再续期,

🔎:定时任务实现有多种方式,常见的实现方式有JUC的任务调度线程池ScheduledExecutorService、Spring提供的

@Scheduled注解以及SchedulingConfigurer接口实现以及第三方任务调度框架Quartz Scheduler、Elastic Job、分布式定时任务xxl-job、PowerJob等,但是这些定时任务不适用于这种场景,主要原因是分布式锁的使用比较随意,如果每有一个分布式锁就使用一个定时任务,使用框架对定时任务的管理不是很灵活;JUC的任务调度线程池可以通过控制线程池的线程数控制定时任务的个数,但是因为其基于线程池,不方便控制每个线程的定时任务

也可以创建一个新线程定义一个任务让其阻塞一段时间就去执行一次续期任务

自动续期在业务方法没执行完锁过期时用程序再次进行续期,如果服务器宕机,续期也会自动终止,续期不会导致锁出现死锁现象

演示JUC的任务调度线程池的局限性

JUC定时任务的销毁没有单独一个定时任务的销毁方法,唯一的关闭定时任务的API是

shutdown()或者shutdownNow()会直接把整个定时任务线程池销毁,没有停掉一个定时任务的方法,想要某个任务停掉就很麻烦,所以JUC中的定时调度任务在这里也很不好用🔎:老师说这里适合使用

java.util.Timer这个工具类来实现定时调度任务,Timer中创建定时任务和取消定时任务的方法都有,使用起来更方便;但是JUC的老师说Timer的优点是简单易用,但是致命缺点是所有的任务都是被同一个线程执行的,同一时间只能有一个任务执行,剩下任务都得等,执行过程中如果有一个任务发生延迟或者异常都会影响后续其他任务的执行,异常甚至会导致后续任务作废;

【JUC任务调度线程池使用示例】

xxxxxxxxxxpublic static void schedule(){ScheduledExecutorService scheduledExecutorService = Executors.newScheduledThreadPool(3);System.out.println("定时任务初始时间:"+System.currentTimeMillis());scheduledExecutorService.scheduleAtFixedRate(()->{System.out.println("定时任务的执行时间:"+System.currentTimeMillis());},5,10,TimeUnit.SECONDS);}java.util.Timer的使用void--->timer.schedule(TimerTask task, long delay, long period)功能解析:定义定时任务,task是任务对象,TimeTask是抽象类,需要实现抽象run方法;delay是初始延迟时间,单位是毫秒,period是两次执行的间隔时间,单位是毫秒

使用示例:

xxxxxxxxxx/*** Thread[main,5,main]| 定时任务初始时间:172418119 1863* Thread[Timer-0,5,main]| 定时任务执行时间:17241811 96874* Thread[Timer-0,5,main]| 定时任务执行时间:17241812 06887* Thread[Timer-0,5,main]| 定时任务执行时间:17241812 16889* Thread[Timer-0,5,main]| 定时任务执行时间:17241812 26904* */public static void main(String[] args) {System.out.println(Thread.currentThread()+"| 定时任务初始时间:"+System.currentTimeMillis());new Timer().schedule(new TimerTask() {public void run() {System.out.println(Thread.currentThread()+"| 定时任务执行时间:"+System.currentTimeMillis());}},5000,10000);}示例含义:定时线程启动后初始延时5秒钟开始每隔十秒打印定时任务执行时间

补充说明:

🔎:

TimerTask实现了Runnable接口

基于

Redis+java.util.Timer+lua脚本来实现自动续期的可重入分布式锁分布式锁的自动续期lua脚本逻辑

脚本逻辑:如果当前线程上的锁存在,就调用

expire指令对锁进行续期,续期成功返回1,如果当前线程的锁不存在,就直接返回0

xxxxxxxxxxif(redis.call('hexists', KEYS[1], ARGV[1]) == 1) thenredis.call('expire', KEYS[1], ARGV[2]);return 1;elsereturn 0;end结合Java代码和lua脚本实现锁的自动续期

这个自动续期的定时调度任务的实现是只让定时调度任务执行一次,续期成功以后原定时调度任务线程直接结束销毁,由原定时调度任务再起一个新的定时调度任务执行下一个续期任务,这样的好处是续期任务定时线程会自己结束,当锁被释放以后定时调度任务就会自动停止设置下一个续期任务,能够灵活地避免考虑自动定时任务自动停止和意外情况下的停止问题,避免意外情况下发生无限续期导致死锁问题的发生

xxxxxxxxxxpublic class DistributedRedisLock implements Lock {private StringRedisTemplate redisTemplate;private String lockName;private String hashField;private long expire = 30;public DistributedRedisLock(StringRedisTemplate redisTemplate, String lockName, String uuid) {this.redisTemplate = redisTemplate;this.lockName = lockName;this.hashField = uuid + ":" + Thread.currentThread().getId();}public void lock() {this.tryLock();}public void lockInterruptibly() throws InterruptedException {}//无参tryLock方法是使用默认有效时间30s作为锁的有效时间public boolean tryLock() {try {return this.tryLock(-1L, TimeUnit.SECONDS);} catch (InterruptedException e) {e.printStackTrace();}return false;}/*** 加锁方法* @param time* @param unit* @return* @throws InterruptedException*/public boolean tryLock(long time, TimeUnit unit) throws InterruptedException {if (time != -1){this.expire = unit.toSeconds(time);}String script = "if redis.call('exists', KEYS[1]) == 0 or redis.call('hexists', KEYS[1], ARGV[1]) == 1 " +"then " +" redis.call('hincrby', KEYS[1], ARGV[1], 1) " +" redis.call('expire', KEYS[1], ARGV[2]) " +" return 1 " +"else " +" return 0 " +"end";while (!this.redisTemplate.execute(new DefaultRedisScript<>(script, Boolean.class), Arrays.asList(lockName), hashField, String.valueOf(expire))){Thread.sleep(50);}// 加锁成功,返回之前,开启定时器自动续期this.renewExpire();return true;}/*** 解锁方法*/public void unlock() {String script = "if redis.call('hexists', KEYS[1], ARGV[1]) == 0 " +"then " +" return nil " +"elseif redis.call('hincrby', KEYS[1], ARGV[1], -1) == 0 " +"then " +" return redis.call('del', KEYS[1]) " +"else " +" return 0 " +"end";Long flag = this.redisTemplate.execute(new DefaultRedisScript<>(script, Long.class), Arrays.asList(lockName), hashField);if (flag == null){throw new IllegalMonitorStateException("this lock doesn't belong to you!");}}public Condition newCondition() {return null;}//上锁以后延迟1/3锁有效时间去定时执行续期脚本;注意execute方法会自动将lua的返回值1转成true,将返回值0返回false,注意nil也会转成false;如果需要区分nil需要使用Long类型的返回值,对应nil转成null;注意这个返回值不能写成Integer类型,会抛出大量异常,转成数字一律使用使用Long避免抛异常//定时任务采用延时执行一次任务,执行完以后线程就销毁,如果续期成功再次执行该任务,续期失败说明锁已经不是当前线程的锁了,不再进行续期操作;如果不这么写就需要去解锁成功以后取消定时任务,需要考虑各种意外情况导致定时线程无法被取消导致的死锁的情况,实现起来比较复杂,但是这种实现在分布式锁比较多的情况下会占用很多的线程资源//这里更改此前的getId方法是因为定时续期的execute方法也需要获取field字段,但是不能使用getId中的逻辑,因为定时任务需要开新的定时任务线程,但是field字段需要业务线程的线程id,因此这里只是改进将getId的逻辑放到了获取锁时的实例化锁对象的构造方法中,实际上锁重入只是key和Field字段相同,实际上锁重入并不是同一个DistributedRedisLock对象private void renewExpire(){String script = "if redis.call('hexists', KEYS[1], ARGV[1]) == 1 " +"then " +" return redis.call('expire', KEYS[1], ARGV[2]) " +"else " +" return 0 " +"end";new Timer().schedule(new TimerTask() {public void run() {if (redisTemplate.execute(new DefaultRedisScript<>(script, Boolean.class), Arrays.asList(lockName), hashField, String.valueOf(expire))) {renewExpire();}}}, this.expire * 1000 / 3);}}

测试

测试环境:

1️⃣:100个用户线程,1s内每个用户线程发起50次扣减库存请求,总共发起5000次,场景为请求连接nginx负载均衡两个运行实例操作虚拟机上的同一个Redis数据库的同一个共享数据,使用上述基于

Redis+java.util.Timer+lua脚本来实现自动续期的可重入分布式锁对库存数量5000进行单次扣减1,累计5000次扣减请求

测试结果:

1️⃣:没预热情况下吞吐量553,5000次扣减操作全部成功,Redis中库存数据应从5000减至0,实际是0,没有出现线程安全问题

小结

比较完善的基于Redis的分布式锁实现如下

分布式锁

DistributedRedisLockxxxxxxxxxxpublic class DistributedRedisLock implements Lock {private StringRedisTemplate redisTemplate;private String lockName;private String hashField;private long expire = 30;public DistributedRedisLock(StringRedisTemplate redisTemplate, String lockName, String uuid) {this.redisTemplate = redisTemplate;this.lockName = lockName;this.hashField = uuid + ":" + Thread.currentThread().getId();}public void lock() {this.tryLock();}public void lockInterruptibly() throws InterruptedException {}//无参tryLock方法是使用默认有效时间30s作为锁的有效时间public boolean tryLock() {try {return this.tryLock(-1L, TimeUnit.SECONDS);} catch (InterruptedException e) {e.printStackTrace();}return false;}/*** 加锁方法* @param time* @param unit* @return* @throws InterruptedException*/public boolean tryLock(long time, TimeUnit unit) throws InterruptedException {if (time != -1){this.expire = unit.toSeconds(time);}String script = "if redis.call('exists', KEYS[1]) == 0 or redis.call('hexists', KEYS[1], ARGV[1]) == 1 " +"then " +" redis.call('hincrby', KEYS[1], ARGV[1], 1) " +" redis.call('expire', KEYS[1], ARGV[2]) " +" return 1 " +"else " +" return 0 " +"end";while (!this.redisTemplate.execute(new DefaultRedisScript<>(script, Boolean.class), Arrays.asList(lockName), hashField, String.valueOf(expire))){Thread.sleep(50);}// 加锁成功,返回之前,开启定时器自动续期this.renewExpire();return true;}/*** 解锁方法*/public void unlock() {String script = "if redis.call('hexists', KEYS[1], ARGV[1]) == 0 " +"then " +" return nil " +"elseif redis.call('hincrby', KEYS[1], ARGV[1], -1) == 0 " +"then " +" return redis.call('del', KEYS[1]) " +"else " +" return 0 " +"end";Long flag = this.redisTemplate.execute(new DefaultRedisScript<>(script, Long.class), Arrays.asList(lockName), hashField);if (flag == null){throw new IllegalMonitorStateException("this lock doesn't belong to you!");}}public Condition newCondition() {return null;}//锁自动续期private void renewExpire(){String script = "if redis.call('hexists', KEYS[1], ARGV[1]) == 1 " +"then " +" return redis.call('expire', KEYS[1], ARGV[2]) " +"else " +" return 0 " +"end";new Timer().schedule(new TimerTask() {public void run() {if (redisTemplate.execute(new DefaultRedisScript<>(script, Boolean.class), Arrays.asList(lockName), hashField, String.valueOf(expire))) {renewExpire();}}}, this.expire * 1000 / 3);}}工厂方法获取分布式锁对象

xxxxxxxxxxpublic class DistributedLockClient {private StringRedisTemplate redisTemplate;private String uuid;public DistributedLockClient() {this.uuid = UUID.randomUUID().toString();}public DistributedRedisLock getRedisLock(String lockName){return new DistributedRedisLock(redisTemplate, lockName, uuid);}}业务方法使用分布式锁示例

业务逻辑是并发请求对100个用户线程,1s内每个用户线程发起50次扣减库存请求,总共发起5000次,操作虚拟机上的同一个Redis数据库的同一个共享数据,对库存数量5000进行单次扣减1,累计5000次扣减请求,使用基于Redis的分布式锁解决Redis中共享库存数据的并发线程安全问题

xxxxxxxxxxpublic void deduct() {DistributedRedisLock redisLock = this.distributedLockClient.getRedisLock("lock");redisLock.lock();try {// 1. 查询库存信息String stock = redisTemplate.opsForValue().get("stock").toString();// 2. 判断库存是否充足if (stock != null && stock.length() != 0) {Integer st = Integer.valueOf(stock);if (st > 0) {// 3.扣减库存redisTemplate.opsForValue().set("stock", String.valueOf(--st));}}} finally {redisLock.unlock();}}

该分布式锁实现了以下特性

通过

setnx指令做到分布式锁的独占排他,后面用lua脚本一次提交执行和Redis单线程特性保证原子性并结合lua脚本的逻辑判断替换了setnx指令的独占排他通过设置过期时间来防服务宕机或者意外锁无法释放导致的死锁现象,使用完整的set指令来保证独占排他并同时设置有效时间保证上锁和设置有效时间两步操作的原子性,最后被lua脚本整合到同时实现上锁和锁重入的

hincrby指令和Expire指令中,用Lua脚本保证上锁或锁重入与设置有效时间两步操作的原子性通过Redis中的Hash数据类型,以key作为锁的唯一标识,以key加field字段【当前线程创建的UUID】作为线程自身上锁的唯一标识来防止当前线程误删其他线程上的锁,避免因为锁提前失效或者一系列其他原因导致的非上锁线程执行锁释放操作;后为了在定义方法时就确定同一个线程锁重入的自动识别,uuid很难实现在方法定义时就保证方法锁重入时两把锁的uuid相同,因此将当前线程标识即field字段重新设计为

线程id,为了避免集群环境下不同服务实例的线程id相同导致上锁通过锁重入获取锁导致锁失效问题,使用uuid作为服务的唯一标识,field字段使用uuid:线程id结合key作为区分获取锁的当前线程的唯一标识使用lua脚本保证加锁和设置锁过期时间、判断锁是当前线程上的锁和释放锁、判断锁是当前线程上的锁和为锁续期多步操作的原子性

分布式锁的不可重入也可能会导致死锁,用Hash数据类型,key作为锁唯一标识,key和field【

uuid:线程id】作为当前线程的唯一标识来做锁重入、锁释放和锁续期中锁属于当前线程的判断标识、以value作为锁重入次数的计数,该设计模仿可重入锁的锁重入实现方式,用lua脚本保证检查锁和操作锁多步操作的原子性使用JDK的Timer定时器和lua脚本实现可重入锁的自动续期

在Redis主从集群下这种分布式锁可能会因为主机宕机,从机还没来得及同步上锁数据,从升级为主,另一个请求从新主中获取到锁导致锁机制失效,此时就需要使用红锁算法

锁内部操作实现的逻辑

加锁操作经过四个版本的迭代,其中上锁重试可以使用递归也可以使用循环重试

版本1:基于Redis一行指令

setnx上锁实现独占排他问题:客户端宕机和不可重入引发死锁、不可重入、扩展功能原子性得不到保障

版本2:基于Redis的完整

set <key> <value> [Ex seconds] [Px milliseconds] [NX|XX]指令实现排他独占,上锁和设置锁有效时间两步操作的原子性问题:不具备可重入性仍然存在死锁问题,引入锁有效期出现锁提前过期,错误上锁导致锁失效,锁被错误释放

版本3:基于Redis的Hash数据类型+lua脚本实现带有效时间解决锁错误释放的可重入锁,lua脚本的上锁逻辑是

1️⃣:根据key即锁的名称使用Redis指令

exists判断锁是否占用,如果对应key的记录不存在说明锁没有被占用,可以直接获取锁hset/hincrby并设置锁过期时间expire防客户端宕机导致死锁,用lua脚本保证以上操作的原子性2️⃣:如果锁被占有则通过key和field【

uuid:线程id】判断当前线程是否占有锁的线程hexists,是就进行锁重入hincby并设置锁的过期时间expire3️⃣:key对应名称的锁被占用且不是当前线程占用,获取锁失败,使用客户端代码进行重试

问题:没有解决锁提前失效的问题,多个线程可能同时运行导致锁失效

版本4:在版本3的基础上基于JDK的Timer定时器和lua脚本实现锁的自动续期,用延时单次定时任务和上一个定时调度线程成功执行才设置下一个定时续期调度线程的方式避开解决意外状况下的定时任务无法停止的问题,用lua脚本保证判断锁被当前线程占用并为锁续期两步操作的原子性

解锁操作经过三个版本的迭代

版本1:使用Redis单步指令

del删除键值对来释放锁问题:

del指令不能删除键值对的同时检查键值对的value,可能导致误删🔎:误删是删除非当前线程占有的锁

版本2:使用lua脚本保证多步Redis指令的原子性的前提下先判断value再删除键值对释放锁

问题:锁重入的情况下

uuid很难实现对同一把锁进行锁重入和重入后的释放

版本3:基于Redis的Hash数据类型+lua脚本在实现锁重入的基础上对value重入计数进行累加累减以及用uuid+线程id作为线程唯一标识实现对可重入锁的解锁,lua脚本的解锁逻辑为

1️⃣:判断锁是否当前线程占有的锁,不是直接返回nil,将来直接在程序中抛出异常

2️⃣:如果是当前线程占有的锁,对重入计数直接减1

hincrby -1,判断减完后的value是否为0,为0直接删除键值对释放锁,lua脚本返回删除键值对的执行结果,1表示释放成功3️⃣:如果value值不为0则直接返回0

基于Redis的分布式锁现存问题

在现有实现的基础上仍然存在单点故障的问题,即目前的分布式锁只存在于单台Redis服务器上,如果该服务器挂掉,所有的分布式锁都会失效

🔎:企业开发一般都使用Redis集群,搭建Redis主从集群,配合哨兵机制在主挂掉的时候将从升级为主

Redis集群下的上述分布式锁面临的困难

Redis主从集群,对分布式锁的更新操作如上锁都在主中完成,然后主将更新操作通过IO操作记录到RDB日志或者AOF日志中,从从主中拉取日志需要发生网络IO操作,IO操作比较耗时,可能发生从还没有来得及同步更新操作日志主就宕机了,此时配合sentinel哨兵机制从升级为新的主,此时获取锁的线程正在执行业务方法,另一个请求如果也来获取锁,此时新升级的主中并没有同步成功对应的上锁操作,新的请求仍然能成功上锁并同时执行业务方法,此时就可能会发生并发线程安全问题

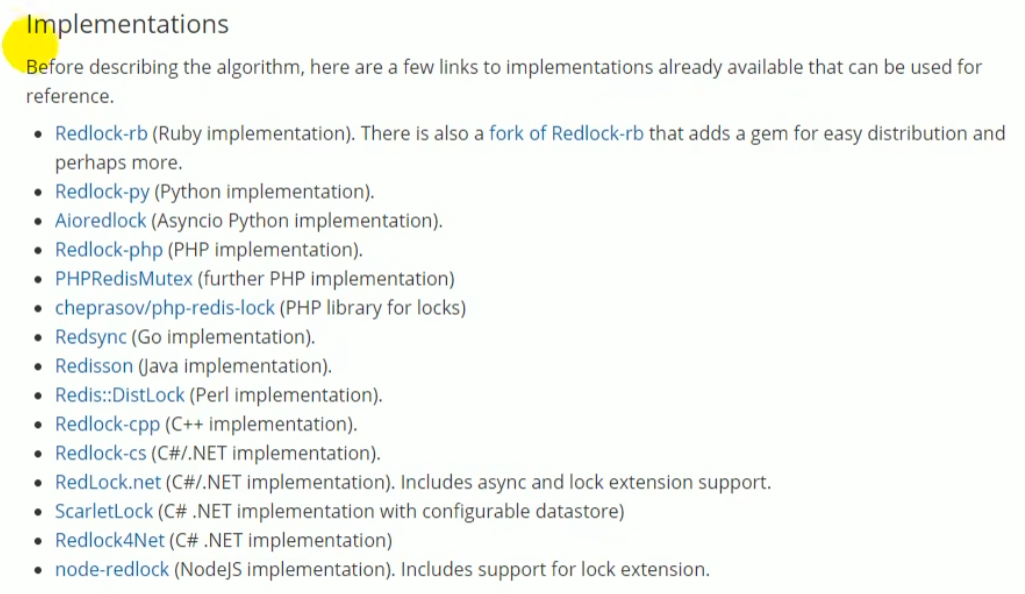

红锁算法

红锁算法是Redis官方提供的针对分布式锁集群下失效的算法机制,英文名为RedLock,红锁算法是Redis特有的,其他的应用中没有这种算法机制,Redis官方关于红锁的英文参考文档地址为:https://redis.io/topics/distlock

红锁算法的原理

🔎:这个红锁算法实现起来很麻烦,实际开发中很少使用,性能由于多redis节点串行获取锁也很难保证,对redis的集群设置也很偏门,一般互联网公司能搭建一个redis主从集群防单点故障就很不错了,这个老师只讲了实现步骤,没讲原理,没有对其具体实现

红锁算法下的Redis集群

红锁算法下的多个Redis节点没有主从关系也没有哨兵机制,相互之间完全独立,需要部署到不同的服务器或者虚拟机中,相互之间也不知道对方的存在

应用程序10010加锁过程

1️⃣:在获取锁以前应用程序需要获取系统当前时间作为获取锁的起始时间来计算从Redis集群中获取锁的总消耗时间

2️⃣:应用程序依次从所有节点上先后获取锁,使用set、setnx或者hset指令获取锁都可以,看业务要求,但是要保证所有节点都以同样的方式获取锁且需要保证键值对的key和value必须一样;依次获取锁的时候每个Redis节点都要设置超时时间,设置超时时间的目的是为了避免某个节点宕机,客户端一直尝试从该节点获取锁一直获取不到,如果超过指定时间获取不到就要去尝试从下一个节点获取锁,直到所有节点都尝试完了

3️⃣:计算所有节点获取锁消耗的时间,包括获取锁失败的节点的耗时时间,在锁没有自动续期的情况下,当获取锁的耗时小于锁的过期时间才任务锁获取成功【锁没有获取到不会进行续期动作】,且获取锁的耗时时间要远小于锁的过期时间,否则即使获取到锁也认为是获取锁失败了;在该前提下还要满足半数以上的节点【N / 2 + 1个】获取到锁才认为锁获取成功

4️⃣:获取到锁以后应用程序还要通过锁的有效时间减去获取锁总消耗时间得到锁的剩余有效时间,这也是实际锁的有效时间,剩余有效时间到了以后Redis集群自动释放锁

5️⃣:如果获取锁失败了【获取锁的消耗时间大于锁的有效时间或者少于半数的节点成功获取锁】,要对所有的节点释放锁,即使有些节点获取锁失败了该节点也需要释放锁,因为应用程序不知道哪些节点获取锁成功了,应用程序只知道有多少个节点获取锁成功了,所有节点都调用

del指令释放锁

应用程序10010解锁过程

1️⃣:解锁直接对每个节点释放锁使用del指令删除键值对释放锁即可,获取锁成功的直接删除锁,获取锁失败的删除锁失败也无所谓,根据业务场景需要决定是否使用lua脚本保证原子性或者防误删

Redisson

Redisson类似于Jedis,功能封装相较于Jedis更加丰富,Jedis只是一个性能很好的Redis客户端,功能太弱;Redisson中封装了很多类似分布式锁、Java常用分布式对象【BitSet, Set, Multimap, SortedSet, Map, List, Queue, BlockingQueue, Deque, BlockingDeque, Semaphore, Lock, AtomicLong, CountDownLatch, Publish / Subscribe, Bloom filter】,常用分布式服务的实现;

这些分布式对象或者集合和单机版的一些对象集合在设计上考虑的点不一样,都是分布式场景下的Set、Map、List集合、队列,双端队列、双端阻塞队列、阻塞队列、信号量、分布式锁、原子整数等等

🔎:单机版的集合中只能放本地对象供本地操作,分布式环境下的集合可以存放分布式系统内的所有机器上的对象并放在如Redis中供大家共享操作

此外还有一些基于Redis实现的分布式远程服务

Redisson提供了很多使用Redis最方便简单的方法,和Jedis的设计理念不同,jedis的目的就是在客户端使用Redis指令,Redisson的目的是让用户不要关注redis本身和对应的指令,只关注使用Redisson实现业务逻辑

Redisson是一个在Redis的基础上实现的Java驻内存数据网格,内存数据网格的意思就是给内存做格式化,格式化的意思是给存储介质画格子,可以向格子中写入数据;格式化达到清空数据的效果是一种表面现象,实际动作是画格子【解释的一坨】,早期的U盘购买以后不能直接用,需要下驱动格式化才能使用,这个步骤就是给U盘画格子;格式化看上去清空了数据,实际上是在重新画格子【猜测是移除旧的寻址数据,设置新的写入空间,写入数据的时候设置新的寻址规则】

Redisson的官方文档:https://github.com/redisson/redisson/wiki

Redisson中的对锁自动续期的机制就叫看门狗机制

配置Redisson

引入依赖

pom.xml🔎:

我严重怀疑有场景启动器,这里的配置是使用原生redisson的配置【经过后期确认,Maven仓库确实有对应的场景启动器依赖org.redisson.redisson-spring-boot-starter,配置示例后面遇到再补充】

xxxxxxxxxx<dependency> <groupId>org.redisson</groupId> <artifactId>redisson</artifactId> <version>3.17.1</version></dependency> 配置

Properties中没有提供对应的Redisson相关的配置项,不能在SpringBoot的默认配置文件中对Redisson进行配置,具体的配置方法可以参考文档的Configuration【配置方法】章节,可以通过代码、文件的方式对Redisson进行配置

Redisson可以通过用户提供的YAML格式的文本文件来进行配置,该YAML文件需要通过调用静态方法

Config.fromYAML(new File("config-file.yaml"))来创建Config配置类对象,通过配置类对象调用静态方法Redisson.create(Config config)来实例化RedissonClient对象,这个RedissonClient对象就类似于操作Redis的StringRedisTemplate,Redisson通过该对象实现对Redis的所有操作,配置示例如下xxxxxxxxxxConfig config = Config.fromYAML(new File("config-file.yaml"));RedissonClient redisson = Redisson.create(config);YAML的文件配置方式比较麻烦,程序化配置相对简单方便,程序化配置的方法是构造一个Config对象,调用对象的实例方法为该对象设置指定的参数,配置示例如下,推荐使用程序化配置方式

Redis地址必须以

redis://开头,后面跟redis服务器的ip和端口号

xxxxxxxxxxConfig config = new Config();config.setTransportMode(TransportMode.EPOLL);config.useClusterServers()//可以用"rediss://"来启用SSL连接.addNodeAddress("redis://127.0.0.1:7181");

配置Redis集群的模式

针对Redis以不同模式构建,RedissonClient的配置方式不同,但是也是大同小异,Redis常见的构建模式包括集群模式、云托管模式、单Redis节点模式、哨兵模式、主从模式、分片模式;配置对应模式的代码如下

【单机模式】

xxxxxxxxxxConfig config = new Config();config.useSingleServer();【分片模式】

参数

addresses是一个可变长度字符串类型参数,在分片模式下要传递多个Redis节点的地址

xxxxxxxxxxConfig config = new Config();config.useClusterServers().addNodeAddress(String... addresses);【自定义模式】

xxxxxxxxxxConfig config = new Config();config.useCustomServers();【主从模式】

xxxxxxxxxxConfig config = new Config();config.useMasterSlaveServers();【副本模式】

xxxxxxxxxxConfig config = new Config();config.useReplicatedServers();【哨兵模式】

xxxxxxxxxxConfig config = new Config();config.useSentinelServers();

单Redis节点模式下的程序化配置方式

如果redis在本机,Redisson可以直接使用create方法以默认连接地址

127.0.0.1:6379初始化RedissonClient,示例如下xxxxxxxxxx// 默认连接地址 127.0.0.1:6379RedissonClient redisson = Redisson.create();如果redis不在本机,配置redis的模式、配置redis服务器地址和端口并用

Redisson.create(config)方法初始化RedissonClient,示例如下xxxxxxxxxxConfig config = new Config();//设置配置对应的Redis模式并设置对应的Redis地址config.useSingleServer().setAddress("myredisserver:6379");RedissonClient redisson = Redisson.create(config);常用配置示例

xxxxxxxxxxpublic class RedissonConfig{public RedissonClient redissonClient(){Config config = new Config();//初始化一个Redisson配置对象config.useSingleServer()//使用单机模式.setAddress("redis://192.168.200.132:6173")//指定Redis服务器地址.setDatabase(0)//Redis默认有16个数据库,Redisson可以通过`setDatabase(int database)`方法进行指定,默认传参0表示使用第一个数据库.setUsername(String username).setPassword()//设置用户名和密码,当redis设置了用户名和密码,对应的Config也需要配置.setConnectionMinimumIdleSize(10)//设置连接池最小空闲连接数,生产环境最好设置,开发环境无需设置.setConnectionPoolSize(50)//设置连接池最大线程数[这里怀疑是连接数不是线程数,因为连接池不一定需要使用线程池].setIdleConnectionTimeout(60000)//设置连接池线程的最大空闲时间,单位是毫秒,连接池线程空闲超过该时间就会被销毁直到线程数小于连接池最小空闲数.setConnectionTimeout()//设置客户端程序获取redis连接的超时时间,如果超过该时间客户端还没有获取到redis连接就会快速失败.setTimeout();//设置响应超时时间,如果超过指定时间还没有响应就快速失败RedissonClient redisson = Redisson.create(config);return redisson;}}最小配置示例

这只是最简单的配置,定制化的配置还有很多,需要翻阅文档,在该配置下可以使用Redisson提供的:

🔎:同时也意味着其他的配置都是可选配置,但是老师说生产环境上面的常用配置项都需要进行配置

基于Redis的分布式锁RLock

Redisson是接口RedissonClient的实现类,Redisson的构造方法使用protected修饰,不能在包以外的地方调用,用户无法使用该构造方法;用户需要使用create方法来创建RedissonClient对象无参的

create()方法默认写死了本机的6379作为redis服务器地址,也是调用有参的create方法创建RedissonClient对象有参的

create(Config config)方法通过调用Redisson的构造方法传参config来创建RedissonClient对象

xxxxxxxxxxpublic class RedissonConfig{public RedissonClient redissonClient(){Config config = new Config();config.useSingleServer().setAddress("redis://192.168.200.132:6173");RedissonClient redisson = Redisson.create(config);return redisson;}}

RedissonClient相关API

等于没讲,空了自己总结,这里只是重点讲了一下获取分布式锁

RLock--->redissonClient.getLock(String name)功能解析:获取一个名为

name的分布式锁对象使用示例:

RLock lock = redissonClient.getLock("lock")示例含义:获取一个名为

lock的基于Redis的分布式锁对象

补充说明:

RBloomFilter<V>--->redissonClient.getBloomFilter(String name)功能解析:获取布隆过滤器

使用示例:``

示例含义:

补充说明:

RBloomFilter<V>--->redissonClient.getBloomFilter(String name,Codec codec)功能解析:获取布隆过滤器

使用示例:``

示例含义:

补充说明:

RAtomicDouble--->redissonClient.getAtomicDouble(String name)功能解析:获取原子操作对象

RAtomicDouble使用示例:``

示例含义:

补充说明:

RAtomicLong--->redissonClient.getAtomicLong(String name)功能解析:获取原子操作对象

RAtomicLong使用示例:``

示例含义:

补充说明:

RLock

RedissonLock的底层原理就是上面基于Redis实现分布式锁的原理,只是相比于上面的实现多了CompletableFuture异步编排技术、反射式Reactive和RxJava2标准来实现的,解锁相较于上面多了一个自动续期和发布订阅,定时重置有效时间使用的netty的时间轮,早期也使用的JDK的Timer,说白了就是老师是仿Redisson的实现来演示自己实现一个基于Redis的分布式锁除了

RedissonLock,Redisson在文档第八章分布式锁和同步器提到还提供了其他的锁,比如这个延长锁的有效期机制被Redisson称为监控锁的看门狗,其实就是Timer定时器任务,默认情况下,锁的有效时间和我们自己设计的锁一样是30s,上锁10s以后就会重置一次锁有效时间,只要拿到锁的线程没有运行结束就会一直延长锁的有效期

雷丰阳老师说实际开发中更推荐使用

redissonLock.lock(30,TimeUnit.SECONDS)来明确指定锁自动释放时间,没给出理由,只是说这样可以省掉续期过程并且业务方法执行时间不可能超过30s,超出30s业务就完蛋了,执行完业务方法通过手动解锁的方式来释放锁,弹幕说实战推荐写一个注解,通过AOP加锁解锁

RLock原理RLock的锁以用户获取锁传入的字符串作为key,以uuid作为filed,以重入次数作为value,同样使用Hash数据类型标识锁对象;RLock也继承了JUC的Lock接口,RLock本身是一个接口RLock的lock方法被三个子类RedissonLock、RedissonMultiLock、RedissonSpinLock实现了,这里只关注RedissonLock对lock方法的实现逻辑,RedissonLock继承自RedissonBaseLock,RedissonBaseLock实现了RLock接口,即Redisson默认通过redissonClient.getLock("lock")获取到的锁是RedissonLock,其中的lock方法是对JUC的Lock接口的lock方法的实现,该锁本身就叫可重入锁,可重入原理也是和上面一样的RedissonLock的lock方法该异步上锁方法

tryLockInnerAsync底层就是执行了一个Lua脚本,这个脚本和上面我们自己实现的基于Redis的分布式锁几乎是一模一样的该lua脚本上锁的逻辑是如果锁没有被占用就获取锁并设置有效时间并返回nil;如果锁存在就判断是否是当前线程的锁,是就对重入次数加1重新设置有效时间并返回nil;如果获取不到锁就调用Redis的

pttl指令去获取键值对的毫秒级别过期时间🔎:ttl指令获取的是秒级别的过期时间

上锁成功以后的自动续期会调用

scheduleExpirationRenewal(threadId);方法,最底层是在newTimeout方法中使用netty的时间轮实现io.netty.util.HashedWheelTimer去做定时任务的,实际上Redisson的早期版本使用的就是JUC里面的Timer实现的定时重置过期时间,后面更新的版本中才将Timer换成了netty里面的时间轮;续期脚本在

renewExpirationAsync(long threadId)方法中,也和我们此前的续期逻辑是一样的,先判断锁是否当前线程的锁,如果是就去使用Redis的pexpire指令执行毫秒级别精度的设置键值对的有效期,重置成功返回1,失败返回0;而且也是使用的如果重置有效时间成功还会再去开启一次重置任务,当前任务定时任务会直接销毁的方式

这里面大量使用JUC提供的异步工具类

CompletableFuture进行异步编排,性能比我们实现的分布式锁要好很多注意:

Redisson实现的RedissonLock是阻塞锁,获取不到锁就直接阻塞等待了,直到当前线程释放锁才有机会再去抢占锁,不是采用循环重试的方式来抢占锁

xxxxxxxxxxredisson.lock()public void lock() {try {lock(-1, null, false);1️⃣ //该无参lock方法调用的是重载lock方法void lock(long leaseTime, TimeUnit unit, boolean interruptibly)} catch (InterruptedException e) {throw new IllegalStateException();}}1️⃣ redisson.lock(-1, null, false)//这里实际和ReentrantLock的实现类似,上锁都是在lock方法中去调用tryAcquire方法private void lock(long leaseTime, TimeUnit unit, boolean interruptibly) throws InterruptedException {long threadId = Thread.currentThread().getId();Long ttl = tryAcquire(-1, leaseTime, unit, threadId);1️⃣-1️⃣ //第一个参数的变量名是waitTime,注意这里面传入来的waitTime是-1,这个值是可以自定义设置的,就是Config这个类里面的lockWatchDogTimeout这个属性,代表锁的过期时间,如果没自定义设置就是30// lock acquired,如果返回的ttl为null说明锁获取成功了,第一次尝试获取锁成功会直接返回if (ttl == null) {return;}CompletableFuture<RedissonLockEntry> future = subscribe(threadId);pubSub.timeout(future);RedissonLockEntry entry;if (interruptibly) {entry = commandExecutor.getInterrupted(future);} else {entry = commandExecutor.get(future);}try {//如果第一次获取锁失败会进入死循环不停调用tryAcquire方法尝试获取锁,直到ttl等于null表示获取锁成功也会跳出循环直接返回while (true) {ttl = tryAcquire(-1, leaseTime, unit, threadId);// lock acquiredif (ttl == null) {break;}// waiting for messageif (ttl >= 0) {try {entry.getLatch().tryAcquire(ttl, TimeUnit.MILLISECONDS);} catch (InterruptedException e) {if (interruptibly) {throw e;}entry.getLatch().tryAcquire(ttl, TimeUnit.MILLISECONDS);}} else {if (interruptibly) {entry.getLatch().acquire();} else {entry.getLatch().acquireUninterruptibly();}}}} finally {unsubscribe(entry, threadId);}// get(lockAsync(leaseTime, unit));}1️⃣-1️⃣ redissonLock.tryAcquire(-1, leaseTime, unit, threadId)//tryAcquire方法调用的是Redisson实现的tryAcquireAsync(waitTime, leaseTime, unit, threadId)方法private Long tryAcquire(long waitTime, long leaseTime, TimeUnit unit, long threadId) {return get(tryAcquireAsync(waitTime, leaseTime, unit, threadId));1️⃣-1️⃣-1️⃣}1️⃣-1️⃣-1️⃣ redissonLock.tryAcquireAsync(waitTime, leaseTime, unit, threadId)//在该方法中调用tryLockInnerAsync(waitTime, leaseTime, unit, threadId, RedisCommands.EVAL_LONG)方法尝试异步加锁,这个是3.17.1版本的源码,和3.12.0版本的源码不同,应该是3.17.1进行了重写private <T> RFuture<Long> tryAcquireAsync(long waitTime, long leaseTime, TimeUnit unit, long threadId) {RFuture<Long> ttlRemainingFuture;if (leaseTime > 0) {ttlRemainingFuture = tryLockInnerAsync(waitTime, leaseTime, unit, threadId, RedisCommands.EVAL_LONG);} else {ttlRemainingFuture = tryLockInnerAsync(waitTime, internalLockLeaseTime,TimeUnit.MILLISECONDS, threadId, RedisCommands.EVAL_LONG);}CompletionStage<Long> f = ttlRemainingFuture.thenApply(ttlRemaining -> {// lock acquiredif (ttlRemaining == null) {if (leaseTime > 0) {internalLockLeaseTime = unit.toMillis(leaseTime);} else {scheduleExpirationRenewal(threadId);}}return ttlRemaining;});return new CompletableFutureWrapper<>(f);}//该上锁方法底层就是执行了一个Lua脚本,这个脚本和上面我们自己实现的基于Redis的分布式锁几乎是一模一样的//该lua脚本上锁的逻辑是如果锁没有被占用就获取锁并设置有效时间并返回nil;如果锁存在就判断是否是当前线程的锁,是就对重入次数加1重新设置有效时间并返回nil;如果获取不到锁就调用Redis的pttl指令去获取键值对的毫秒级别过期时间,ttl指令获取的是秒级别的过期时间<T> RFuture<T> tryLockInnerAsync(long waitTime, long leaseTime, TimeUnit unit, long threadId, RedisStrictCommand<T> command) {return evalWriteAsync(getRawName(), LongCodec.INSTANCE, command,"if (redis.call('exists', KEYS[1]) == 0) then " +"redis.call('hincrby', KEYS[1], ARGV[2], 1); " +"redis.call('pexpire', KEYS[1], ARGV[1]); " +"return nil; " +"end; " +"if (redis.call('hexists', KEYS[1], ARGV[2]) == 1) then " +"redis.call('hincrby', KEYS[1], ARGV[2], 1); " +"redis.call('pexpire', KEYS[1], ARGV[1]); " +"return nil; " +"end; " +"return redis.call('pttl', KEYS[1]);",Collections.singletonList(getRawName()), unit.toMillis(leaseTime), getLockName(threadId));}//该方法继承自RedissonBaseLock,被tryAcquireAsync在成功获取锁后调用,方法名的意思是定时过期时间重置//实现逻辑是先获取锁的信息,调用renewExpiration()方法来做锁续期protected void scheduleExpirationRenewal(long threadId) {ExpirationEntry entry = new ExpirationEntry();ExpirationEntry oldEntry = EXPIRATION_RENEWAL_MAP.putIfAbsent(getEntryName(), entry);if (oldEntry != null) {oldEntry.addThreadId(threadId);} else {entry.addThreadId(threadId);try {renewExpiration();} finally {if (Thread.currentThread().isInterrupted()) {cancelExpirationRenewal(threadId);}}}}//该方法继承自RedissonBaseLock,被scheduleExpirationRenewal方法调用,这就是执行定时过期时间重置的方法//此前我们的实现是new Timer().schedule(new TimerTask(){})来使用jdk的Timer创建定时任务,这里使用的是newTimeout方法传参TimerTask来执行定时任务,private void renewExpiration() {ExpirationEntry ee = EXPIRATION_RENEWAL_MAP.get(getEntryName());if (ee == null) {return;}//实际是这一步去做定时任务的,通过下面的newTimeout方法源码分析可知是使用netty的时间轮实现io.netty.util.HashedWheelTimer去做定时任务的,定时任务的逻辑是在TimerTask中定义的Timeout task = commandExecutor.getConnectionManager().newTimeout(new TimerTask() {public void run(Timeout timeout) throws Exception {ExpirationEntry ent = EXPIRATION_RENEWAL_MAP.get(getEntryName());if (ent == null) {return;}Long threadId = ent.getFirstThreadId();if (threadId == null) {return;}//这个renewExpirationAsync(threadId)方法里面有执行续期逻辑的lua脚本,这里面定义了续期的lua脚本CompletionStage<Boolean> future = renewExpirationAsync(threadId);future.whenComplete((res, e) -> {if (e != null) {log.error("Can't update lock " + getRawName() + " expiration", e);EXPIRATION_RENEWAL_MAP.remove(getEntryName());return;}if (res) {// reschedule itself//如果重置有效时间成功还会再去开启一次重置任务,当前任务定时任务会直接销毁renewExpiration();} else {cancelExpirationRenewal(null);}});}}, internalLockLeaseTime / 3, TimeUnit.MILLISECONDS);ee.setTimeout(task);}//该方法是接口ConnectionManager的抽象方法,被唯一实现类MasterSlaveConnectionManager实现了,该抽象方法只有一个实现,MasterSlaveConnectionManager有四个子类,全部调用的是父类该方法的实现,该方法被renewExpiration()方法调用//这里有一个Debug技巧,遇到这种看方法源码的,直接使用快捷键Ctrl+Alt+B替代Ctrl+B跳转,如果是抽象方法运气好只有一个实现直接跳转不会跳转到抽象类或者接口中去,运气不好就到每个对应的实现去看吧,也可以打断点,但是搭环境不太方便public Timeout newTimeout(TimerTask task, long delay, TimeUnit unit) {try {//与我们的实现不同,Redisson中的定时任务使用的是netty的io.netty.util.HashedWheelTimer时间轮实现的,Redisson的早期版本使用的就是JUC里面的Timer,后面更新的版本中才将Timer换成了netty里面的时间轮return timer.newTimeout(task, delay, unit);} catch (IllegalStateException e) {if (isShuttingDown()) {return DUMMY_TIMEOUT;}throw e;}}//renewExpirationAsync(long threadId)方法被renewExpiration()调用,是RedissonBaseLock中的方法//这个代码就是定义锁续期的lua脚本,续期逻辑是先判断锁是否当前线程的锁,如果是就去使用Redis的pexpire指令执行毫秒级别精度的设置键值对的有效期,重置成功返回1,失败返回0protected CompletionStage<Boolean> renewExpirationAsync(long threadId) {return evalWriteAsync(getRawName(), LongCodec.INSTANCE, RedisCommands.EVAL_BOOLEAN,"if (redis.call('hexists', KEYS[1], ARGV[2]) == 1) then " +"redis.call('pexpire', KEYS[1], ARGV[1]); " +"return 1; " +"end; " +"return 0;",Collections.singletonList(getRawName()),internalLockLeaseTime, getLockName(threadId));}RedissonLock的unlock方法在

redissonLock.unlockInnerAsync(threadId)方法中定义了解锁的lua脚本,解锁逻辑是先判断锁是否当前线程的锁,不是当前线程的锁直接返回nil;如果是当前线程的锁,定义一个局部变量counter,该局部变量用于接收value减1后的值,如果减1后的计数counter大于0说明锁没解完,重新设置锁的有效时间并返回0;如果减1后的计数counter小于等于0直接删除键值对解锁,使用redis的指令publish发布订阅以后直接返回1表示解锁成功;如果是其他情况仍然返回nil,和我们自己实现的原理是一样的,并在该方法中执行解锁操作释放锁成功以后调用取消定时续期任务的方法

cancelExpirationRenewal(threadId)

xxxxxxxxxx//unlock()方法由用户通过rLock.unlock调用,该方法属于RedissonLock//在该方法中调用父类RedissonBaseLock的unlockAsync(Thread.currentThread().getId()方法进行解锁public void unlock() {try {get(unlockAsync(Thread.currentThread().getId()));} catch (RedisException e) {if (e.getCause() instanceof IllegalMonitorStateException) {throw (IllegalMonitorStateException) e.getCause();} else {throw e;}}// Future<Void> future = unlockAsync();// future.awaitUninterruptibly();// if (future.isSuccess()) {// return;// }// if (future.cause() instanceof IllegalMonitorStateException) {// throw (IllegalMonitorStateException)future.cause();// }// throw commandExecutor.convertException(future);}//redissonBaseLock.unlockAsync(long threadId)由子类redissonLock.unlock()方法调用//redissonBaseLock.unlockAsync(long threadId)调用抽象方法子类实现redissonLock.unlockInnerAsync(threadId)来执行解锁public RFuture<Void> unlockAsync(long threadId) {//释放锁的方法RFuture<Boolean> future = unlockInnerAsync(threadId);CompletionStage<Void> f = future.handle((opStatus, e) -> {//释放锁成功以后调用取消定时续期任务的方法cancelExpirationRenewal(threadId);cancelExpirationRenewal(threadId);if (e != null) {throw new CompletionException(e);}if (opStatus == null) {IllegalMonitorStateException cause = new IllegalMonitorStateException("attempt to unlock lock, not locked by current thread by node id: "+ id + " thread-id: " + threadId);throw new CompletionException(cause);}return null;});return new CompletableFutureWrapper<>(f);}//redissonLock.unlockInnerAsync(threadId)由redissonLock.unlock()调用//redissonLock.unlockInnerAsync(threadId)中定义了解锁的lua脚本,解锁逻辑是先判断锁是否当前线程的锁,不是当前线程的锁直接返回nil;如果是当前线程的锁,定义一个局部变量counter,该局部变量用于接收value减1后的值,如果减1后的计数counter大于0说明锁没解完,重新设置锁的有效时间并返回0;如果减1后的计数counter小于等于0直接删除键值对解锁,使用redis的指令publish发布订阅以后直接返回1表示解锁成功;如果是其他情况仍然返回nil,和我们自己实现的原理是一样的protected RFuture<Boolean> unlockInnerAsync(long threadId) {return evalWriteAsync(getRawName(), LongCodec.INSTANCE, RedisCommands.EVAL_BOOLEAN,"if (redis.call('hexists', KEYS[1], ARGV[3]) == 0) then " +"return nil;" +"end; " +"local counter = redis.call('hincrby', KEYS[1], ARGV[3], -1); " +"if (counter > 0) then " +"redis.call('pexpire', KEYS[1], ARGV[2]); " +"return 0; " +"else " +"redis.call('del', KEYS[1]); " +"redis.call('publish', KEYS[2], ARGV[1]); " +"return 1; " +"end; " +"return nil;",Arrays.asList(getRawName(), getChannelName()), LockPubSub.UNLOCK_MESSAGE, internalLockLeaseTime, getLockName(threadId));}

用法示例1

最常用的就是RLock的无参加锁

lock()方法和unlock()方法这就是使用基于Redis的分布式锁的扣减库存完整代码,相当于将分布式锁封装好了,只需要使用lock方法上锁,unlock方法解锁,业务方法正常调用

StringRedisTemplate对redis中的共享数据进行操作即可就能实现并发线程安全这个共享数据不一定是必须存redis中,分布式锁是限定所有请求都去竞争系统中都可以获取的唯一的锁,系统中所有要获取同一把锁的请求都串行执行业务方法

🔎:注意,老师还是在业务方法中使用

StringRedisTemplate来操作redis中的共享数据的,没有使用redissonClient🔎:注意,前置工作还包括上面的引入Redisson依赖、配置

RedissonClient、实例化RedissonClient对象并将该对象注入容器

xxxxxxxxxxpublic void deduct() {RLock lock = redissonClient.getLock("lock");lock.lock();try {// 1. 查询库存信息String stock = redisTemplate.opsForValue().get("stock").toString();// 2. 判断库存是否充足if (stock != null && stock.length() != 0) {Integer st = Integer.valueOf(stock);if (st > 0) {// 3.扣减库存redisTemplate.opsForValue().set("stock", String.valueOf(--st));}}} finally {lock.unlock();}}测试

测试环境:

1️⃣:100个用户线程,1s内每个用户线程发起50次扣减库存请求,总共发起5000次,场景为请求连接nginx负载均衡两个运行实例操作虚拟机上的同一个Redis数据库的同一个共享数据,使用Redisson的分布式锁并使用上述代码对redis中的共享库存数量5000进行单次扣减1,累计5000次扣减请求

测试结果:

1️⃣:没预热情况下吞吐量873,5000次扣减操作全部成功,Redis中库存数据应从5000减至0,实际是0,没有出现线程安全问题

结果分析:

1️⃣:性能比我们自己封装的基于Redis的分布式锁吞吐量600要好很多,这种专业框架底层会使用很多技术对性能做优化

用法示例2

RLock的重载lock方法

rLock.lock(long leaseTime,TimeUnit unit)的作用是当前线程获取分布式锁,给锁设定有效时间并指定时间单位,当超过有效时间时锁会自动释放,锁生效期间可以手动释放锁,一定注意这个方法是获取锁leaseTime时间间隔以后自动释放锁,锁被释放以后再手动释放锁会抛异常这里会存在一个问题,使用这个方法上锁,如果指定时间为10s自动释放,而锁自动续期时间间隔也是10s,如果使用该方法锁是不会自动续期的,如果此时业务方法还没有执行完,其他的请求线程就能抢占锁了,不仅会发生线程安全问题

调用

rLock.lock(long leaseTime,TimeUnit unit)方法根本不会执行到给锁续期的代码,在下面的1️⃣-1️⃣-1️⃣-1️⃣执行后就直接返回了,如果获取锁成功直接用用户指定时间作为锁的有效时间,到了有效时间就直接自动释放了,这可能可以解释为什么后面基于Zookeeper实现的分布式读写锁,用户的请求线程都已经响应了,但是读锁或者写锁仍然会等到指定时间到了以后才会被释放;如果是无参数上锁方法

rLock.lock()没有指定锁的自动释放时间,会以org.redisson.config.Config中看门狗超时时间属性private long lockWatchdogTimeout = 30 * 1000;默认的30s作为锁的过期时间,并设置一个定时重置过期时间的任务,在下面1️⃣-1️⃣-1️⃣-2️⃣-1️⃣的newTimeout(new TimerTask() {}, internalLockLeaseTime / 3, TimeUnit.MILLISECONDS);指定这个定时任务的触发时间是获取锁后1/3锁的有效时间即看门狗超时时间的三分之一即10s钟将锁的默认有效时间进行重置

加锁方法

rLock.lock(long leaseTime,TimeUnit unit)源码xxxxxxxxxxRedisson3.12.0-----------------------------------------------------------------------------------------------------redissonLock.lock(10,TimeUnit.SECONDS)public void lock(long leaseTime, TimeUnit unit) {try {lock(leaseTime, unit, false);1️⃣ //调用重载方法加锁,注意这种加锁方式是不可打断的,默认interruptibly参数是false} catch (InterruptedException e) {throw new IllegalStateException();}}1️⃣ redissonLock.lock(leaseTime, unit, false)private void lock(long leaseTime, TimeUnit unit, boolean interruptibly) throws InterruptedException {long threadId = Thread.currentThread().getId();//拿到当前线程的线程id并传递给获取锁的方法Long ttl = tryAcquire(leaseTime, unit, threadId);1️⃣-1️⃣ //尝试一次获取锁,返回ttl为null表示获取锁成功,直接结束获取锁方法执行,如果第一次获取锁尝试失败,后续在while死循环中还会进行尝试// lock acquiredif (ttl == null) {return;}RFuture<RedissonLockEntry> future = subscribe(threadId);if (interruptibly) {commandExecutor.syncSubscriptionInterrupted(future);} else {commandExecutor.syncSubscription(future);}try {while (true) {ttl = tryAcquire(leaseTime, unit, threadId);//第一次获取锁失败这里还会尝试获取锁// lock acquiredif (ttl == null) {break;}// waiting for messageif (ttl >= 0) {try {future.getNow().getLatch().tryAcquire(ttl, TimeUnit.MILLISECONDS);} catch (InterruptedException e) {if (interruptibly) {throw e;}future.getNow().getLatch().tryAcquire(ttl, TimeUnit.MILLISECONDS);}} else {if (interruptibly) {future.getNow().getLatch().acquire();} else {future.getNow().getLatch().acquireUninterruptibly();}}}} finally {unsubscribe(future, threadId);}// get(lockAsync(leaseTime, unit));}1️⃣-1️⃣ redissonLock.tryAcquire(leaseTime, unit, threadId)private Long tryAcquire(long leaseTime, TimeUnit unit, long threadId) {return get(tryAcquireAsync(leaseTime, unit, threadId));1️⃣-1️⃣-1️⃣ //这里传递的时间leaseTime就是调用redissonLock.lock(10,TimeUnit.SECONDS)中的自动释放锁的锁有效时间,注意该方法和无参lock方法调用的tryAcquireAsync不是同一个方法,是重载方法}1️⃣-1️⃣-1️⃣ redissonLock.tryAcquireAsync(leaseTime, unit, threadId)private <T> RFuture<Long> tryAcquireAsync(long leaseTime, TimeUnit unit, long threadId) {if (leaseTime != -1) {//如果传递了锁自动释放时间,此时leaseTime就为用户指定的时间,如果调用的是无参lock()方法没指定这个值默认应该为-1return tryLockInnerAsync(leaseTime, unit, threadId, RedisCommands.EVAL_LONG);1️⃣-1️⃣-1️⃣-1️⃣ //如果指定了锁自动释放时间就执行该tryLockInnerAsync方法,目的是尝试使用异步的方式加锁,上锁成功就直接返回了}RFuture<Long> ttlRemainingFuture = tryLockInnerAsync(commandExecutor.getConnectionManager().getCfg().getLockWatchdogTimeout(), TimeUnit.MILLISECONDS, threadId, RedisCommands.EVAL_LONG);//如果是无参lock()方法就会走这里的逻辑,该方法就是去redis中占锁,由于没有指定锁自动释放的时间,会使用配置Cfg中的LockWatchdogTimeout属性指定的时间,默认是30000ms,即看门狗超时时间也就是锁的默认有效时间30s,返回值是RFutrue对象,是JUC中的异步编排的内容,ttlRemainingFuture.onComplete((ttlRemaining, e) -> {if (e != null) {return;}// lock acquiredif (ttlRemaining == null) {scheduleExpirationRenewal(threadId);1️⃣-1️⃣-1️⃣-2️⃣}});//如果占锁成功就会执行监听,参数e表示异常,e不为null即有异常,此时直接返回;如果没有异常且锁成功获取会调用scheduleExpirationRenewal(threadId);调度重置锁过期时间return ttlRemainingFuture;}1️⃣-1️⃣-1️⃣-1️⃣ redissonLock.tryLockInnerAsync(leaseTime, unit, threadId, RedisCommands.EVAL_LONG)<T> RFuture<T> tryLockInnerAsync(long leaseTime, TimeUnit unit, long threadId, RedisStrictCommand<T> command) {internalLockLeaseTime = unit.toMillis(leaseTime);//将获取锁后自动释放的时间间隔转换为毫秒级别的内部锁释放时间return commandExecutor.evalWriteAsync(getName(), LongCodec.INSTANCE, command,"if (redis.call('exists', KEYS[1]) == 0) then " +"redis.call('hset', KEYS[1], ARGV[2], 1); " +"redis.call('pexpire', KEYS[1], ARGV[1]); " +"return nil; " +"end; " +"if (redis.call('hexists', KEYS[1], ARGV[2]) == 1) then " +"redis.call('hincrby', KEYS[1], ARGV[2], 1); " +"redis.call('pexpire', KEYS[1], ARGV[1]); " +"return nil; " +"end; " +"return redis.call('pttl', KEYS[1]);",Collections.<Object>singletonList(getName()), internalLockLeaseTime, getLockName(threadId));//commandExecutor雷丰阳老师说是命令执行的线程池,并在此处将lua脚本发送给redis去异步执行,从这里发现,如果用户指定了锁自动释放时间,第一次上锁不管成功与否,上锁后都会直接返回,不会再执行后面的给锁续期的代码}1️⃣-1️⃣-1️⃣-2️⃣ redissonLock.scheduleExpirationRenewal(threadId)private void scheduleExpirationRenewal(long threadId) {ExpirationEntry entry = new ExpirationEntry();ExpirationEntry oldEntry = EXPIRATION_RENEWAL_MAP.putIfAbsent(getEntryName(), entry);//这一步是给Redis中放东西,但是放什么没说if (oldEntry != null) {oldEntry.addThreadId(threadId);} else {entry.addThreadId(threadId);renewExpiration();1️⃣-1️⃣-1️⃣-2️⃣-1️⃣ //重新给锁设置过期时间}}1️⃣-1️⃣-1️⃣-2️⃣-1️⃣ redissonLock.renewExpiration()private void renewExpiration() {ExpirationEntry ee = EXPIRATION_RENEWAL_MAP.get(getEntryName());if (ee == null) {return;}Timeout task = commandExecutor.getConnectionManager().newTimeout(new TimerTask() {public void run(Timeout timeout) throws Exception {ExpirationEntry ent = EXPIRATION_RENEWAL_MAP.get(getEntryName());if (ent == null) {return;}Long threadId = ent.getFirstThreadId();if (threadId == null) {return;}RFuture<Boolean> future = renewExpirationAsync(threadId);1️⃣-1️⃣-1️⃣-2️⃣-1️⃣-1️⃣future.onComplete((res, e) -> {if (e != null) {log.error("Can't update lock " + getName() + " expiration", e);return;}if (res) {// reschedule itselfrenewExpiration();//注意这是递归调用本方法renewExpiration()}});}}, internalLockLeaseTime / 3, TimeUnit.MILLISECONDS);//获取一个连接管理器,调用newTimeout方法传参一个定时任务,定时任务就是run方法里面的内容,整段内容主要在运行renewExpirationAsync(threadId)方法中的代码ee.setTimeout(task);}1️⃣-1️⃣-1️⃣-2️⃣-1️⃣-1️⃣ redissonLock.renewExpirationAsync(threadId)protected RFuture<Boolean> renewExpirationAsync(long threadId) {return commandExecutor.evalWriteAsync(getName(), LongCodec.INSTANCE, RedisCommands.EVAL_BOOLEAN,"if (redis.call('hexists', KEYS[1], ARGV[2]) == 1) then " +"redis.call('pexpire', KEYS[1], ARGV[1]); " +"return 1; " +"end; " +"return 0;",Collections.<Object>singletonList(getName()),internalLockLeaseTime, getLockName(threadId));//这个就是使用lua脚本执行给锁续期的代码,internalLockLeaseTime是Redisson的long类型参数,在Redisson构造的时候通过`this.internalLockLeaseTime = commandExecutor.getConnectionManager().getCfg().getLockWatchdogTimeout();`仍然获取的是配置的看门狗超时时间,默认是30s,即这个脚本是重置锁的有效期时间到30s}

用法示例3

rLock.tryLock(100,10,TimeUnit.SECONDS)方法的作用是尝试上锁,最多等待100s的时间,100s还是获取不到就放弃抢占锁;如果上锁成功锁的有效期被设置为10s,到了10s以后会自动释放锁

FairLock公平锁

FairLock是基于Redis的分布式可重入公平锁,实现了继承JUC的Lock接口的RLock接口,还提供了异步(Async)、反射式(Reactive)和RxJava2标准的接口,公平锁相对于RedissonLock的公平体现在所有请求线程都会在一个FIFO队列中排队,先发出请求的线程优先获取锁,而RedissonLock全凭运气

排队的线程所在服务器宕机了,Redisson会给该线程5秒钟的等待时间,到底是等谁,服务器都宕机了,线程还存在吗,这文档也写的逆天,那我只能猜测队列节点去尝试发起上锁请求结果等不到解锁回应,下一个节点对应线程就迟迟等待,而且服务器都宕机了,Redisson客户端都挂了,还哪里来的FIFO队列,这官方文档写的也是一坨

FairLock的使用方法和RedissonLock的使用方法是一样的,同时也有监控锁的看门狗机制,锁的有效时间还有10s一次重置都是一样的

代码示例

在请求参数中按顺序发起几个请求,发送时间间隔小于10s,每次请求都传参一个从1开始的整数id,每次请求递增1

最后的运行效果是,控制台每隔10s输出一个数字,输出数字的顺序是按照请求顺序依次输出1、2、3、4、5、6;说明确实是先进入阻塞队列的请求优先获取锁,证明了该锁的公平性;使用

RedissonLock重试一次就会发现id输出顺序是随机的🔎:使用

RedissonLock测试的时候会发现一个请求同时被两个服务实例都接受到并都在控制台输出了相同的id,一个实例输出一次,这是nginx的分发机制导致的,因为这里一直重试迟迟获取不到锁,nginx等待超过一定时间得不到响应就会将请求进行重发,将nginx的请求重发禁用或者将超时时间设置的很长如proxy_connect_timeout 12000;【设置连接超时时间】、proxy_send_timeout 12000;【设置请求发送超时时间】、proxy_read_timeout 12000;【设置响应超时时间】就不会出现这种情况了

对应的Redis中多了一个key为

redisson_lock_queue(1)的锁队列,其中保存着正在排队的线程信息,而且该队列是有顺序保证先进入队列的线程先获取锁

xxxxxxxxxxpublic void testFairLock(Long id){RLock fairLock = redissonClient.getFairLock("fairLock");fairLock.lock();try{TimeUnit.SECONDS.sleep(10)System.out.println(id);}catch(InterruptedException e){e.printStackTrace();}finally{fairLock.unlock();}}

RedissonMultiLock联锁

概念:

联锁是需要至少三台Redis服务器,每个Redis服务器都对应的一个redissonClient实例,每个实例去对应的redis服务器中获取一把RLock锁,这些锁的名称最好是一样的,也可以不同;通过各个RedissonClient实例获取到指定名字的锁,通过联锁对象

RedissonMultiLock的构造方法传参三个锁对象【从这里看得出来,三个redissonClient实例都在一个客户端应用程序上,否则无法传参三个锁对象到一个方法里】返回一个RedissonMultiLock锁对象,通过该对象的lock方法和unlock方法来实现加锁和解锁

用法示例

xxxxxxxxxxRLock lock1 = redissonInstance1.getLock("lock1");RLock lock2 = redissonInstance2.getLock("lock2");RLock lock3 = redissonInstance3.getLock("lock3");RedissonMultiLock lock = new RedissonMultiLock(lock1, lock2, lock3);// 同时加锁:lock1 lock2 lock3// 所有的锁都上锁成功才算成功。lock.lock();...lock.unlock();特点

联锁通过

redissonMultiLock上锁成功的标志是联锁构造方法参数列表的每个锁都上锁成功,联锁才算上锁成功,只要有一个锁上锁失败,联锁就上锁失败;这意味着只要有对应的任何一台redis服务器宕机,这个联锁上锁就一定会失败,因此这个锁的使用场景很有限,尽量避免使用

RedissonRedLock红锁

概念

RedissonRedLock实现了Redis的红锁算法,该对象也可以将来自不同RedissonClient实例对象获取到的锁对象通过RedissonRedLockd的构造方法关联为一个红锁,对应的含义是从不同的Redis服务器获取到的锁关联为一个红锁对象,通过红锁对象的lock方法加锁、unlock方法解锁;

🔎:比联锁好在大部分节点加锁成功加锁就算成功,Redis给出的标准是大于节点数的一半加1,红锁了解一下就行,实际企业开发使用红锁的寥寥无几

用法示例

xxxxxxxxxxRLock lock1 = redissonInstance1.getLock("lock1");RLock lock2 = redissonInstance2.getLock("lock2");RLock lock3 = redissonInstance3.getLock("lock3");RedissonRedLock lock = new RedissonRedLock(lock1, lock2, lock3);// 同时加锁:lock1 lock2 lock3// 红锁在大部分节点上加锁成功就算成功。lock.lock();...lock.unlock();

RReadWriteLock读写锁

读读并发,读锁不会阻塞读锁,效果就和无锁是一样的,只会在redis中记录所有的读锁,并将mode字段设置为read

读写互斥,读锁阻塞写锁,写锁阻塞非当前线程读锁,JUC里面的读写锁支持先上写锁,相同线程还可以获取读锁,称为锁降级

写写互斥,占有写锁的线程会阻塞其他想要获取写锁的线程

概念

基于Redis的Redisson分布式可重入读写锁,该对象实现了JUC中的

java.util.concurrent.locks.ReadWriteLock接口,读锁和写锁都继承了RLock接口,JDK中的读写锁是读读并发,读写和写写互斥读写不能并发设计目的是为了避免写的过程中读到脏数据,比如Mysql中的select for update,执行该语句会直接上悲观锁阻塞其他写操作,但是不会阻塞select操作,在修改还没有提交以前读取到旧数据,在特定场景下比如减库存的场景下就会导致超卖现象,因此有些场景下要控制不能读写并发;JUC的读写锁的实现原理是读锁是Shared类型的锁,写锁释放前检查AQS中的后续节点,如果是Shared类型的节点就释放连续一段Shared类型节点直到再次遇到要上写锁的独占类型节点,写锁等到所有的读锁都释放掉了才会被唤醒尝试获取锁

🔎:普通的锁也只是实现多线程写互斥,读操作如果不加锁,在写的过程中读操作不会被阻塞,即普通的锁也是读写并发的,因为使用普通的锁一般不会对读操作上锁,此时读就可能读到脏数据;但是读写锁读写也是互斥的,普通的锁做不到读写锁的效果

但是有些场景下对一致性要求不那么严格也有对应读写并发的实现,比如JUC中的

CopyOnWriteArrayList,支持多线程读单线程写,实现原理是更新操作通过复制一个新的数组来执行更新操作,读取操作还是在旧数组中进行